Jeszcze niedawno cała uwaga wokół Samsunga skupiała się na jego litograficznych ambicjach, rywalizacji z TSMC i kontraktach na 2 nm układy dla Tesli czy AMD. Koreański gigant wyraźnie jednak nie zamierza odpuszczać również swojemu drugiemu, nie mniej groźnemu rywalowi z Tajwanu – firmie SK Hynix. Tym razem polem walki jest nie produkcja chipów, a rynek pamięci HBM, kluczowy element układów wykorzystywanych w rozwiązaniach AI i GPU nowej generacji.

Jak donosi serwis WCCFTech, Samsung rozpoczął agresywną obniżkę cen pamięci HBM3E, co może znacząco wpłynąć na układ sił w tym segmencie. Według nieoficjalnych informacji, firma oferuje swoje moduły taniej o 5 do 10% w stosunku do konkurencyjnych rozwiązań SK Hynix. Co ważne – nie mówimy o przecenie starszych generacji, ale o najnowszej linii HBM3E, która trafia m.in. do akceleratorów AI i zaawansowanych GPU – w tym układów NVIDIA Blackwell.

HBM3E – klucz do dominacji w AI

Dlaczego ta zmiana jest tak istotna? Bo to właśnie pamięci HBM (High Bandwidth Memory) stanowią dziś jedno z głównych wąskich gardeł w rozwoju i produkcji akceleratorów AI. NVIDIA, AMD, Intel czy nawet start-upy pokroju Tenstorrent potrzebują ich więcej niż kiedykolwiek. To od dostępności i ceny HBM często zależy termin dostaw i koszt gotowego rozwiązania.

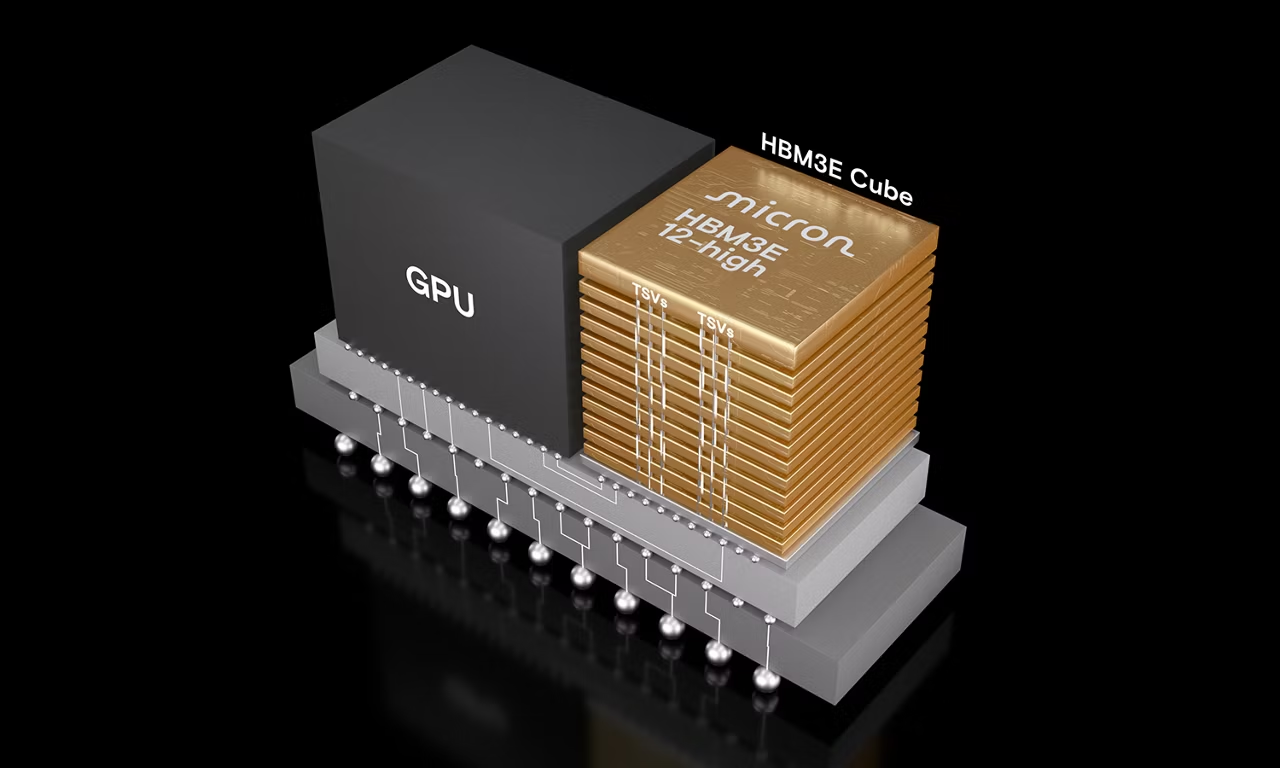

Pamięci High Bandwidth Memory (HBM) to nie jest zwykły RAM. W przeciwieństwie do tradycyjnych modułów DDR, HBM3E to zaawansowane, pionowo ułożone stosy układów, które komunikują się z procesorem graficznym (GPU) za pomocą szerokiej, ultrakrótkiej ścieżki. Taka architektura zapewnia ogromną przepustowość danych, która jest absolutnie kluczowa dla wydajności w zadaniach związanych ze sztuczną inteligencją, takich jak trenowanie dużych modeli językowych (LLM).

Szerokość interfejsu HBM3E sięga 1024 bitów na stos, co w połączeniu z wysoką częstotliwością zegara, pozwala na transfer danych z niewyobrażalną prędkością liczoną w terabajtach na sekundę. Dla porównania, w typowej karcie graficznej GDDR6X szerokość szyny wynosi zazwyczaj 384 bity. Właśnie dzięki temu HBM3E jest tak pożądane przez gigantów technologicznych, którzy inwestują w rozwój AI, a przede wszystkim przez NVIDIE, dominującego gracza na rynku kart AI.

Samsung od dłuższego czasu starał się wejść na rynek, który dotychczas zdominowany był przez Taiwańczyków. SK Hynix, który przez lata był liderem w segmencie HBM, obecnie dostarcza ponad 60% rynku tych układów. Samsung z kolei, mimo sporych inwestycji, pozostawał w cieniu, czekając na moment, by zaatakować. Wygląda na to, że ten moment właśnie nadszedł.

Czy NVIDIA zmieni dostawcę?

Nieoficjalnie mówi się, że Samsung bardzo mocno zabiega o kontrakty z NVIDIA, która obecnie opiera się głównie na dostawach od SK Hynix. Obniżka cen to jasny sygnał: jesteśmy gotowi przejąć większą część rynku, oferując nie tylko nowoczesne układy, ale też lepsze warunki cenowe. Jeśli NVIDIA zdecyduje się zdywersyfikować dostawców, a wiele na to wskazuje, może to oznaczać przełom w udziale Samsunga w rynku AI.

Warto też przypomnieć, że Samsung już wcześniej informował o gotowości do masowej produkcji HBM3E 12- i 16-warstwowych układów, co daje mu przewagę w kwestii skalowalności i dostępności. Teraz, z nową strategią cenową, może szybko nadrobić zaległości względem konkurencji.

Wszystko wskazuje na to, że Samsung prowadzi wielotorową strategię ofensywy na rynku zaawansowanych półprzewodników. Z jednej strony, walka z TSMC o dominację w litografii 2 nm, z drugiej, atak cenowy na SK Hynix w segmencie pamięci HBM. Obie ścieżki prowadzą do tego samego celu: być kluczowym dostawcą technologii dla rewolucji AI.