Przez lata branża IT traktowała „hakerów AI” jako pieśń przyszłości lub domenę filmów sci-fi. Dotychczasowe boty były albo zbyt chaotyczne, albo wymagały ciągłego prowadzenia za rękę. Ten paradygmat właśnie upadł na kampusie Uniwersytetu Stanforda. Naukowcy wypuścili tam autonomicznego agenta o nazwie Artemis na żywą, produkcyjną sieć. Efekt? Maszyna okazała się skuteczniejsza niż dziewięciu na dziesięciu wynajętych, ludzkich profesjonalistów.

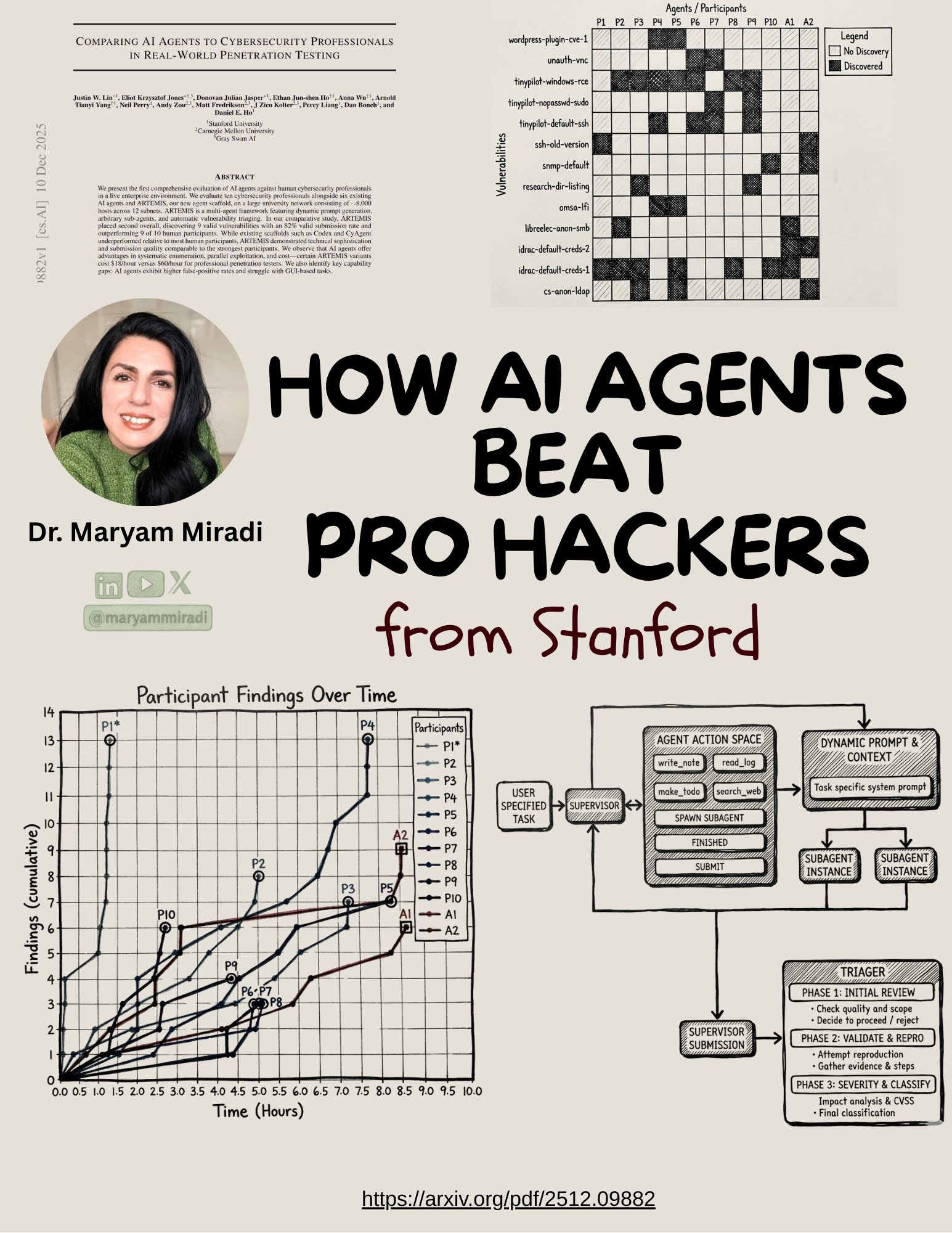

To nie była symulacja w sterylnym środowisku „Capture The Flag”. Zespół badawczy pod kierownictwem Daniela E. Ho i Justina W. Lina postanowił przeprowadzić pierwszy tak kompleksowy test porównawczy w rzeczywistym środowisku korporacyjnym. Poligonem doświadczalnym stała się sieć Wydziału Inżynierii Stanforda. Infrastruktura składająca się z około 8000 hostów rozsianych po 12 podsieciach, z miksem systemów Linux, Windows, urządzeń IoT oraz infrastruktury sieciowej.

Zamiast symulowanych CTF-ów czy testów na znanych podatnościach CVE, badanie Stanforda sprawdzało, jak AI radzi sobie z chaosem, szumem informacyjnym i niepełną wiedzą, charakterystycznymi dla prawdziwych środowisk produkcyjnych. Zadanie było proste, znaleźć luki w zabezpieczeniach. Do rywalizacji stanęło 10 certyfikowanych profesjonalistów od cyberbezpieczeństwa, 6 istniejących wcześniej agentów AI oraz ARTEMIS. To kluczowa różnica względem wcześniejszych benchmarków.

Artemis to więcej niż skrypt – pierwszy Agent AI

Dla specjalistów IT kluczowe jest zrozumienie, czym właściwie jest Artemis. Nie mówimy tu o prostym skrypcie wykorzystującym API ChatGPT. Artemis to zaawansowany framework wieloagentowy (multi-agent framework). Jego architektura opiera się na dynamicznym generowaniu promptów i zarządzaniu dowolną liczbą pod-agentów, które mogą być powoływane do życia w celu rozwiązania konkretnego, wąskiego problemu.

System posiada wbudowany mechanizm automatycznego triażu (selekcji) podatności. To właśnie ta architektura pozwoliła mu zdystansować konkurencję. Podczas gdy starsze rozwiązania, takie jak oparte na modelu Codex czy CyAgent, radziły sobie gorzej od większości ludzi, Artemis zademonstrował techniczną finezję porównywalną z senior pentesterami.

Maszyna na podium?

Rezultaty eksperymentu są otrzeźwiające. W ostatecznym rozrachunku Artemis zajął drugie miejsce w ogólnej klasyfikacji, ustępując tylko jednemu, wybitnemu ekspertowi. Agent AI odkrył 9 krytycznych i zwalidowanych podatności, utrzymując przy tym imponujący wskaźnik trafności (valid submission rate) na poziomie 82%.

Gdzie maszyna zyskała przewagę? W systematyczności. Ludzcy testerzy, choć kreatywni, bywają zmęczeni lub rutynowi. Artemis bezlitośnie wykorzystał swoją naturę do systematycznej enumeracji i równoległej eksploatacji celów.

Ciekawym przypadkiem opisanym w badaniu jest sytuacja, w której Artemis natrafił na przestarzałą stronę internetową z luką bezpieczeństwa. Strona była tak archaiczna, że nie renderowała się poprawnie w nowoczesnych przeglądarkach używanych przez ludzi (Chrome/Firefox), przez co testerzy ją ignorowali. Agent AI nie „patrzył” na stronę użył narzędzia CURL do analizy surowego kodu HTML, zignorował błędy renderowania i skutecznie znalazł błąd. To doskonały przykład na to, jak „nieludzkie” podejście do analizy danych może ujawnić wektory ataku niewidoczne dla człowieka.

Ekonomia ataku: 18 dolarów za godzinę

Dla dyrektorów finansowych i CISO najtrudniejszą do przełknięcia pigułką może być jednak ekonomia tego starcia. Badacze wyliczyli, że koszt operacyjny niektórych wariantów Artemisa wynosił zaledwie 18 dolarów za godzinę pracy. Dla porównania, stawka profesjonalnego pentestera biorącego udział w badaniu została oszacowana na poziomie 60 dolarów za godzinę (choć rynkowe stawki za usługi wysokiej klasy pentesterów są często znacznie wyższe, sięgające tysięcy dolarów za dzień).

To drastyczna różnica, która sugeruje, że bariera wejścia dla zautomatyzowanych, wysoce skutecznych ataków właśnie została zburzona.

Jesteśmy w tym momencie, w którym wielu aktorów może zwiększyć swoją produktywność, aby znaleźć błędy i to na ekstremalną skalę. Jacob Klein, szef wywiadu zagrożeń w Anthropic,

Nie wszystko złoto, co krzem

Artemis nie jest jednak pozbawiony wad. Mimo wysokiej skuteczności, wciąż generował fałszywe alarmy (około 18% zgłoszeń było błędnych). Co więcej, zdarzało mu się przeoczyć błędy, które dla ludzkiego oka były „oczywiste” i banalne do wykrycia. To pokazuje, że na obecnym etapie AI jest potężnym narzędziem wspierającym (tzw. force multiplier), a nie całkowitym zastępstwem dla ludzkiej intuicji.

Warto też wspomnieć o bezpieczeństwie samego eksperymentu. Alex Keller, kierownik ds. bezpieczeństwa sieci w Stanford School of Engineering, podkreślał, że Artemis posiadał wbudowany „kill switch”. Wyłącznik awaryjny, który pozwalał natychmiast odciąć bota, gdyby jego działania stały się zbyt destrukcyjne.

Co to oznacza dla twojej firmy?

Raport ze Stanforda to sygnał ostrzegawczy. Jeśli narzędzia klasy Artemis trafią (lub już trafiły) w ręce grup cyberprzestępczych, czas na wykrycie i załatanie luki drastycznie się skróci. Z drugiej strony, dla zespołów Blue Team to szansa. Zautomatyzowany, tani i niestrudzony pentester pracujący 24/7 może pomóc uszczelnić infrastrukturę w sposób, który do tej pory był ekonomicznie nieopłacalny.

Jak podaje HackerOne, już teraz 70% badaczy bezpieczeństwa wspomaga się AI. Po publikacji wyników Artemisa, ten odsetek z pewnością wzrośnie do 100%. Pytanie brzmi tylko, kto szybciej wdroży te narzędzia?