Gdy w świecie IT pada hasło „komputery kwantowe”, często kojarzy się to z czymś odległym, laboratoryjnym, futurystycznym. IBM właśnie udowodnił, że ten etap powoli się kończy. Najnowsze procesory kwantowe Nighthawk i Loon, to nie prezentacje koncepcyjne, lecz realne układy, które trafią do chmury i centrów danych szybciej, niż większość branży się spodziewała. I co najważniejsze: według IBM pierwsze potwierdzone przypadki quantum advantage, momentu, w którym kwant przebije klasyczne obliczenia, mogą zostać oficjalnie zweryfikowane już w 2026 roku.

IBM Nighthawk – kwantowy krok w stronę przewagi nad klasycznymi systemami

Historia Nighthawka zaczyna się od nowej, bardziej „produkcyjnej” myśli inżynieryjnej. IBM nie zwiększa już tylko liczby kubitów; zmienia sposób, w jaki one ze sobą współpracują. Nighthawk to 120 kubitów połączonych 218 strojonymi sprzęgaczami. To ponad 20% więcej niż w poprzedniej generacji. W praktyce oznacza to mniej błędów i możliwość budowania obwodów kwantowych o 30% większej złożoności niż na Heronie, dotychczasowym „wołku roboczym” kwantowego portfolio IBM.

Co ciekawe, chip powstał tak, by od początku myśleć o skalowaniu: najpierw 5 000 bramek dwukubitowych, potem 7 500 (w 2026 r.), 10 000 (w 2027 r.), a na końcu nawet 15 000 bramek w 2028 r. Do tego dochodzą długozasięgowe sprzęgacze i ścieżka do systemów z ponad 1000 kubitami. Brzmi jak eksperyment? Nic z tego. Nighthawk ma trafić do użytkowników IBM Quantum Platform pod koniec 2025 roku. I to on ma być pierwszym procesorem zaprojektowanym specjalnie pod praktyczne quantum advantage.

IBM Loon – gdy celem nie jest moc, lecz niezawodność

Drugi z zaprezentowanych układów, IBM Quantum Loon, jest zupełnie inny. Jeśli Nighthawk jest „silnikiem”, to Loon jest „układem nerwowym” przyszłych komputerów kwantowych. To właśnie w nim IBM testuje wszystkie elementy niezbędne do budowy fault-tolerant systemów, takich, które działają mimo błędów i szumów, będących naturalną częścią kwantowej natury.

Loon wykorzystuje wielowarstwowe trasy sygnałowe, długie sprzęgacze („c-couplers”) łączące nawet odległe kubity i resetowanie kubitów w trakcie pracy. To architektura przygotowana do stosowania kodów korekcji błędów qLDPC, kwantowego odpowiednika tego, co w klasycznym świecie pozwala komputerom działać niezawodnie.

IBM nie poprzestaje na teorii, pojawił się nawet pokaz praktyczny. Na klasycznym układzie HPC firma zademonstrowała dekodowanie błędów w czasie poniżej 480 ns, i to rok przed planowanym terminem. Razem z Loonem daje to wizję realnych, skalowalnych, odpornych komputerów kwantowych w horyzoncie 2029 roku.

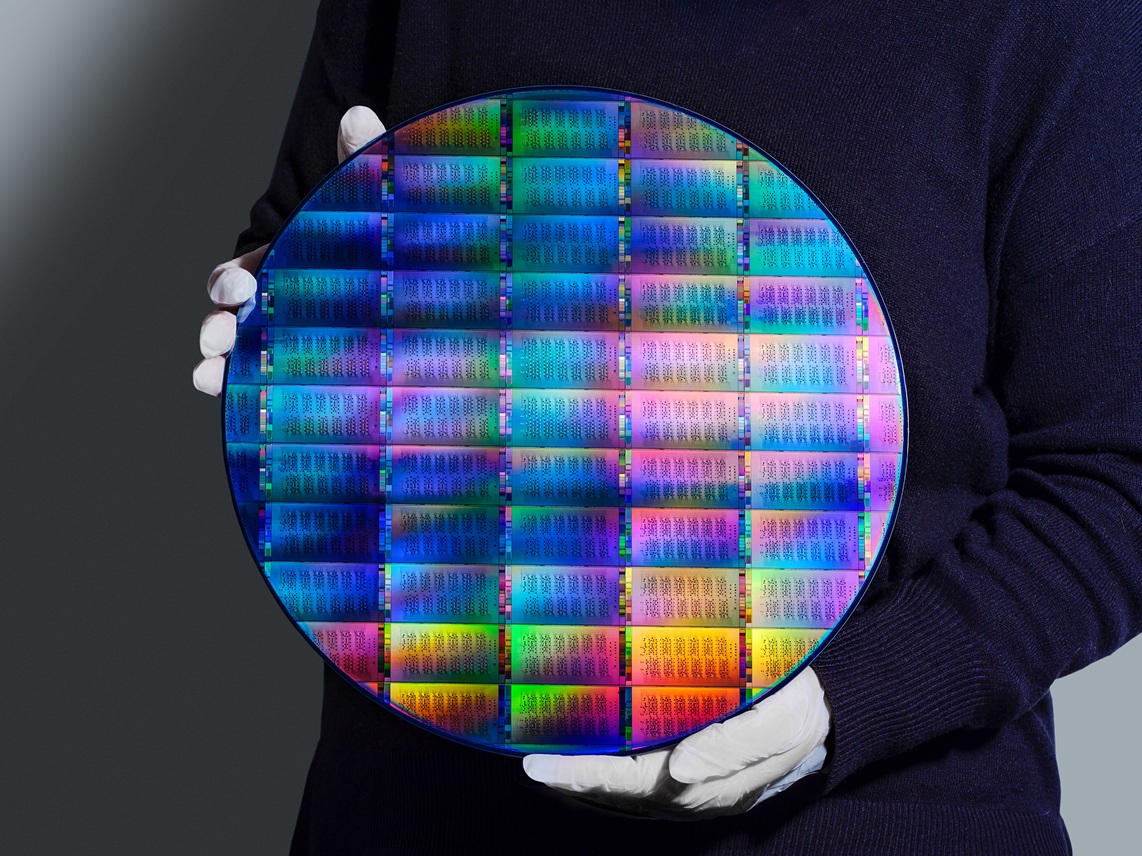

Prawdziwa rewolucja? Nowy sposób produkcji i dopracowane oprogramowanie

Zaskakujące jest jednak coś innego: najcichszy, choć najbardziej game-changing element ogłoszeń.

IBM przenosi produkcję procesorów kwantowych do fabryki półprzewodników NY Creates’ Albany NanoTech, działającej w standardzie 300-mm wafli, takim samym, jaki stosuje się przy produkcji współczesnych CPU i GPU. Ta zmiana robi różnicę:

- czas tworzenia nowych układów skrócił się o połowę,

- złożoność fizyczna chipów wzrosła dziesięciokrotnie,

- możliwe stało się prowadzenie kilku projektów jednocześnie,

- a całość działa w 24/7 jak pełnoprawna fabryka klasy premium.

W praktyce oznacza to, że rozwój komputerów kwantowych przestaje być ograniczony eksperymentalną produkcją „w małej skali”. To wejście w etap przemysłowy, dokładnie ten sam, który dekady temu pozwolił klasycznym komputerom osiągnąć dzisiejszy poziom.

Co z oprogramowaniem? Tu również zaszła cicha, ale znacząca rewolucja. IBM mocno integruje swoje nowości ze stosem Qiskit. Nowe możliwości tzw. obwodów dynamicznych (dynamic circuits) już teraz dają 24-procentowy wzrost dokładności obliczeń na ponad 100 kubitach.

Co więcej, IBM wprowadza nowy interfejs C-API, który pozwala łączyć moc kwantową z klasycznymi superkomputerami (HPC). To jest właśnie przyszłość chmury hybrydowej, ścisła integracja zasobów klasycznych i kwantowych, która (jak twierdzi firma) pozwala obniżyć koszt uzyskiwania precyzyjnych wyników ponad stukrotnie. IBM nie tylko obiecuje, ale i dostarcza konkretne elementy infrastruktury – od krzemu po oprogramowanie, aby przewaga kwantowa stała się faktem szybciej, niż myślimy.