Przez ostatnie kilkanaście miesięcy sztuczna inteligencja była w chmurze sprzedawana głównie jako wizja. Ogromne modele, abstrakcyjne obietnice produktywności i marketingowe hasła o „demokratyzacji AI”. Dziś narracja wyraźnie się zmienia. Dostawcy chmury coraz częściej mówią nie o tym, co AI może kiedyś zrobić, ale ile kosztuje, jak ją wdrożyć i gdzie faktycznie ma sens.

Z danych analityków rynku infrastruktury IT wynika, że globalne wydatki na infrastrukturę chmurową osiągnęły w trzecim kwartale 2025 roku poziom ponad 100 mld dolarów, notując wzrost przekraczający 25% rok do roku. To nie jest już wzrost napędzany klasycznym IaaS-em czy migracjami „lift and shift”. Coraz większą część tego rynku pochłania infrastruktura projektowana specjalnie pod AI: akceleratory, pamięć HBM, sieci o niskich opóźnieniach oraz zaawansowane systemy chłodzenia.

Jednocześnie eksperci branżowi zwracają uwagę na istotną korektę strategii hiperskalerów – Google Cloud, AWS i Microsoft Azure. Pierwsza fala oferty AI w chmurze była zorientowana na maksymalną skalę i dostęp do jak największych modeli. Druga, ta, którą obserwujemy dziś, koncentruje się na kontroli kosztów, elastyczności architektury i realnych scenariuszach biznesowych.

Od „AI jako usługi” do „AI jako infrastruktury”

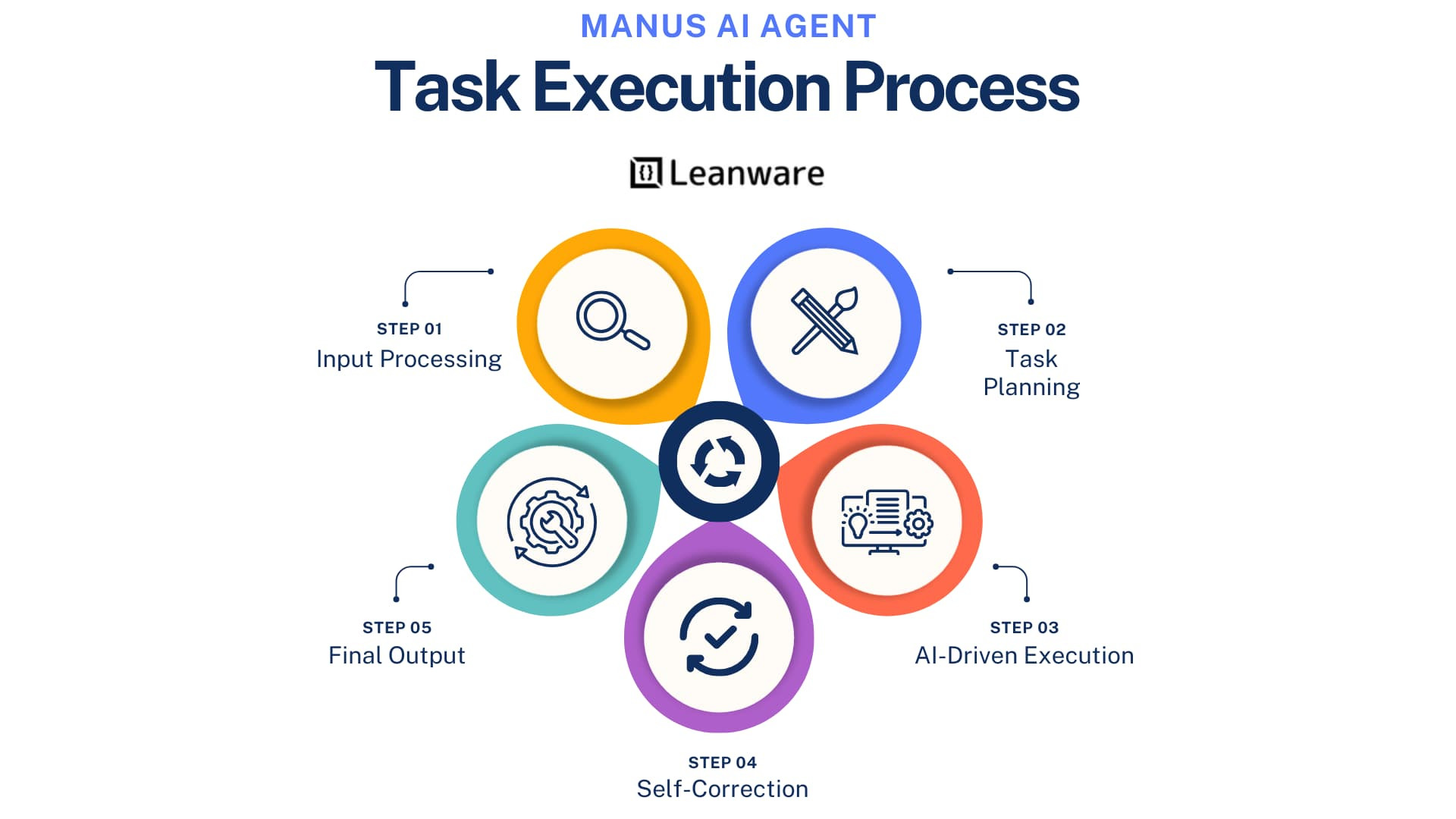

Coraz rzadziej słyszymy o jednej, uniwersalnej platformie AI w chmurze. Zamiast tego dostawcy rozwijają zróżnicowane portfele: osobne instancje do treningu, inne do inferencji, dedykowane środowiska pod modele otwarte i rozwiązania hybrydowe, które pozwalają przenosić część obciążeń bliżej danych.

To podejście nie jest przypadkowe. Wiele organizacji szybko przekonało się, że trening dużych modeli w publicznej chmurze bywa kosztowny i trudny do przewidzenia budżetowo. W efekcie rośnie zainteresowanie architekturami, w których chmura pełni rolę elastycznego zaplecza obliczeniowego, a nie jedynego miejsca przetwarzania AI. Eksperci podkreślają, że hiperskalerzy zaczynają odpowiadać na te potrzeby, oferując bardziej granularne modele rozliczeń, większą kontrolę nad zasobami oraz lepszą integrację z infrastrukturą on-premises i edge.

Sieć, pamięć i energia ważniejsze niż sam model

Zmiana podejścia jest widoczna także w warstwie technicznej. Jeszcze niedawno centrum uwagi stanowiły same modele językowe. Dziś rozmowa coraz częściej dotyczy przepustowości sieci, dostępności pamięci oraz efektywności energetycznej. Analitycy zwracają uwagę, że to właśnie te elementy, a nie same GPU, stają się wąskim gardłem dla wdrożeń AI na dużą skalę. W odpowiedzi dostawcy chmury inwestują w nowe topologie sieciowe, szybsze interkonekty oraz platformy zoptymalizowane pod inferencję, która w dłuższej perspektywie generuje większy wolumen obciążeń niż trening.

AI przestaje być eksperymentem

Najważniejsza zmiana dotyczy jednak podejścia klientów. AI coraz rzadziej traktowana jest jako pilotaż lub eksperyment działu innowacji. Trafia do roadmap IT, planów CAPEX i rozmów o ciągłości działania. To wymusza na hiperskalerach bardziej „enterprise’owe” podejście: przewidywalność, bezpieczeństwo, zgodność regulacyjną i możliwość audytu.

Wszystko wskazuje na to, że chmura wchodzi w etap AI pragmatycznego, mniej efektownego marketingowo, ale znacznie bliższego realnym potrzebom biznesu. Dla działów IT oznacza to jedno: mniej obietnic, więcej architektury. I więcej decyzji, które trzeba podjąć świadomie.

Trzej liderzy nadają tempo zmian

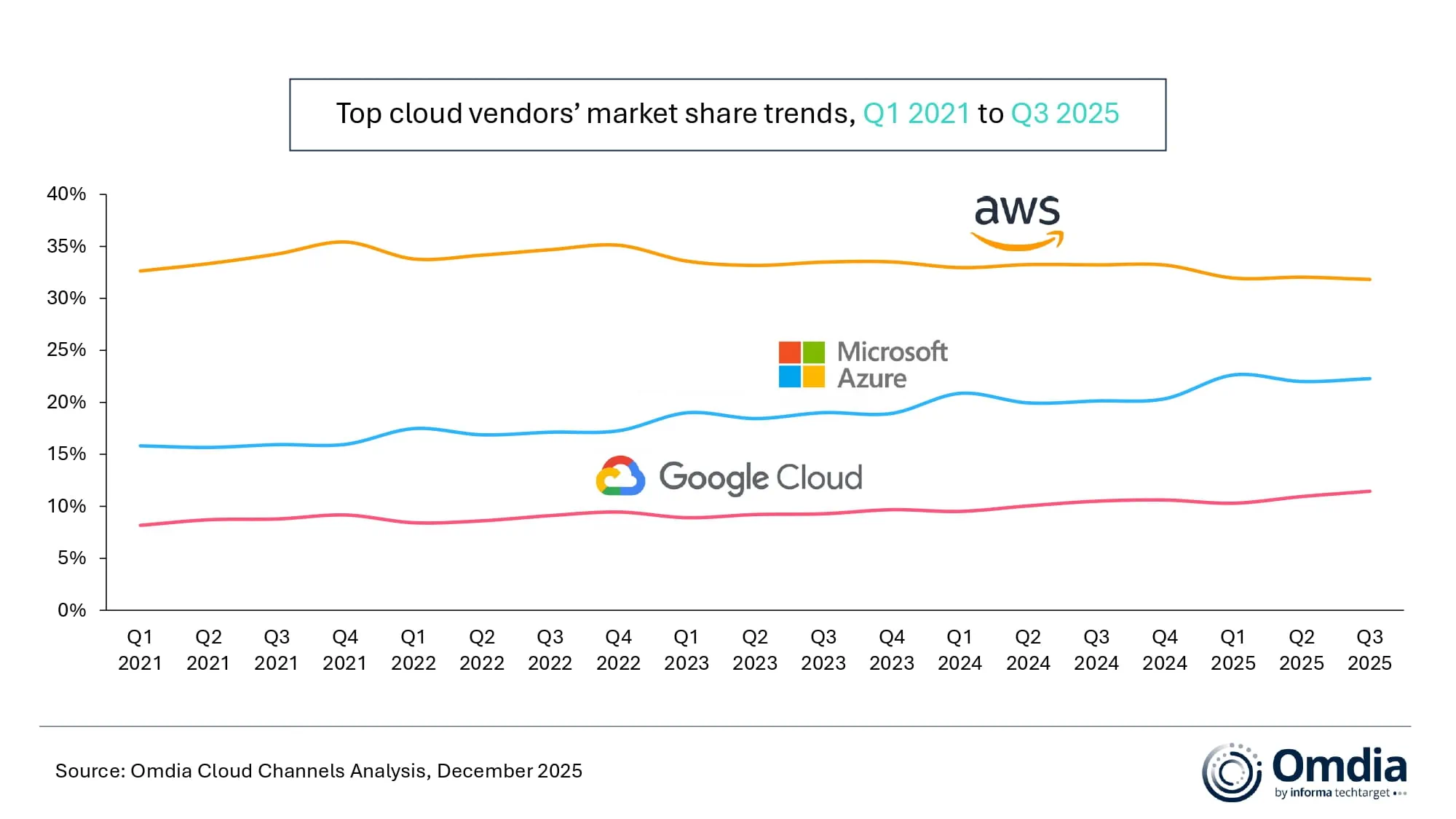

Zmianę podejścia do AI najlepiej widać w wynikach trzech największych dostawców infrastruktury chmurowej, którzy dziś wyznaczają kierunek dla całego rynku. Według danych analityków rynku infrastruktury IT, AWS utrzymuje pozycję zdecydowanego lidera, kontrolując około 32% globalnego rynku chmury infrastrukturalnej. W trzecim kwartale 2025 roku przychody Amazon Web Services wzrosły o blisko 20% rok do roku, co branżowi eksperci wiążą m.in. z poprawą dostępności mocy obliczeniowej oraz rosnącym znaczeniem rozwiązań AI, wspieranych przez strategiczne partnerstwa technologiczne.

Microsoft Azure pozostaje numerem dwa, ale to właśnie ten segment notuje obecnie najwyższą dynamikę wzrostu. Udział Azure w rynku sięga około 22%, a przychody w trzecim kwartale 2025 roku wzrosły aż o 40% rok do roku. Wzrost ten napędzany jest bezpośrednią integracją usług AI z platformą chmurową oraz konsekwentnym osadzaniem narzędzi opartych na generatywnej AI w ofercie dla klientów biznesowych i enterprise.

Na trzecim miejscu znajduje się Google Cloud, który choć wciąż wyraźnie mniejszy od dwóch liderów, pozostaje jednym z najszybciej rosnących graczy. Segment ten zwiększył przychody o około 36% rok do roku, podnosząc swój udział w rynku do 11%. Analitycy wskazują, że kluczowym motorem wzrostu Google Cloud jest rosnące zainteresowanie ofertą AI dla przedsiębiorstw, której kwartalne przychody liczone są już w miliardach dolarów.

Co istotne, mimo różnic w skali, wszyscy trzej dostawcy coraz wyraźniej odchodzą od narracji „AI jako eksperymentu”. Zamiast tego skupiają się na monetyzacji konkretnych przypadków użycia, optymalizacji kosztów infrastruktury oraz budowie stabilnych, długoterminowych fundamentów pod wdrożenia AI w środowiskach produkcyjnych.