Unia Europejska uchwaliła rozporządzenie AI Act, którego nadrzędnym celem jest uregulowanie rozwoju sztucznej inteligencji na terenie Starego Kontynentu. Główna część dokumentu wprowadza klasyfikację AI ze względu na ryzyko generowania przez nią zagrożenia dla obywateli europejskich państw.

Spis treści

Dlaczego Unia Europejska zdecydowała się na wprowadzenie AI Act?

Omawiane przeze mnie rozporządzenie jest odpowiedzią władz Unii Europejskiej na dynamiczny rozwój sztucznej inteligencji na przestrzeni ostatnich lat. Rosnące znaczenie algorytmów AI we współczesnej technologii generuje pewne problemy natury etycznej i rodzi podejrzenia o nieuprawnione wykorzystanie wspomnianych narzędzi przez prywatne podmioty do np.: inwigilacji europejskich użytkowników.

AI Act ma na celu zagwarantowanie odpowiedzialnego rozwoju sztucznej inteligencji i wzmocnienie zaufania społecznego do tego rodzaju technologii. Głównymi adresatami rozporządzenia są firmy wdrażające systemy AI do swoich produktów. Dotyczy to przede wszystkim przedsiębiorstw zajmujących się programami wysokiego ryzyka, o których więcej opowiem w kolejnym akapicie niniejszej publikacji. Już teraz warto jednak nadmienić, że uchwalenie AI Act wiąże się ze sporymi kontrowersjami, a część obserwatorów zauważa, że dokument nałoży ograniczenia na innowacje oraz obejmie je ciężarem regulacyjnym.

AI Act – ten rodzaj sztucznej inteligencji będzie zakazany

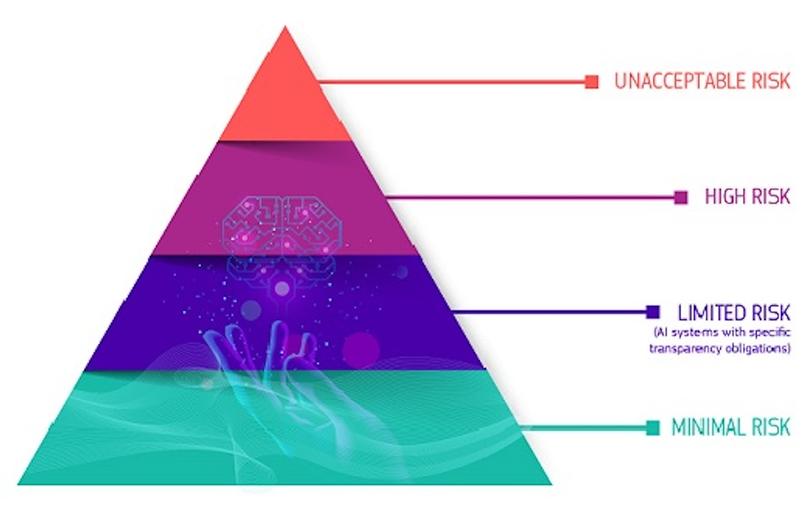

Współczesne systemy AI zostaną podzielone między następujące kategorie:

- wysokiego ryzyka,

- ograniczonego ryzyka,

- minimalnego ryzyka.

Systemy AI wysokiego ryzyka

Wszystkie systemy sztucznej inteligencji, które stanowią wyraźne zagrożenie dla bezpieczeństwa, środków do życia i praw ludzi zostaną zakazane. Dotyczy to zarówno systemów punktacji społecznej stosowanych przez rządy, jak i zabawek wykorzystujących asystencję głosową, które zachęcają do niebezpiecznych zachowań (kategoria – nieakceptowalne ryzyko). Dodatkowo systemy należące do kategorii wysokiego ryzyka obejmują technologie wykorzystywane w:

- infrastrukturze krytycznej (np. transporcie), która może zagrażać życiu i zdrowiu obywateli,

- kształceniu ogólnym lub zawodowym, które może decydować o dostępie do edukacji i ścieżce zawodowej danej osoby (np. punktowanie egzaminów),

- elementach bezpieczeństwa produktów (np. zastosowanie SI w chirurgii robotycznej);

- zatrudnieniu, zarządzaniu pracownikami i dostępie do samozatrudnienia (np. oprogramowanie do sortowania CV w rekrutacji),

- kluczowych usługach prywatnych i publicznych (np. scoring kredytowy uniemożliwiający obywatelom uzyskanie pożyczki),

- egzekwowaniu prawa, które może naruszać podstawowe prawa ludzi (np. ocena wiarygodności dowodów),

- zarządzaniu migracją, azylem i kontrolą granic (np. automatyczna ocena wniosków wizowych),

- administracji sprawiedliwości i procesach demokratycznych (np. rozwiązania SI do wyszukiwania orzeczeń sądowych).

Wszystkie systemy zdalnej identyfikacji biometrycznej również zostały uznane za technologie wysokiego ryzyka i będą podlegały surowym wymaganiom. Zasadniczo zakazane jest wykorzystywanie zdalnej identyfikacji biometrycznej w miejscach publicznych do celów egzekwowania prawa.

Systemy AI ograniczonego ryzyka

Ograniczone ryzyko dotyczy braku przejrzystości w użytkowaniu AI. Akt o sztucznej inteligencji wprowadza szczególne obowiązki dotyczące tej kwestii tak, by budować zaufanie między użytkownikami nowych technologii a ich producentami. Na przykład podczas korzystania z systemów AI, takich jak chatboty, ludzie powinni być informowani, że wchodzą w interakcję z maszyną, aby mogli podjąć świadomą decyzję o kontynuowaniu lub wycofaniu się z rozmowy.

Dostawcy będą musieli również zagwarantować, że treści wygenerowane przez AI zostaną odpowiednio oznaczane. Dotyczy do przede wszystkim audio oraz wideo, które coraz częściej trafiają do opinii publicznej w formie deepfake’ów.

Systemy AI minimalnego ryzyka

Akt o sztucznej inteligencji zezwala na swobodne korzystanie z systemów o minimalnym ryzyku. Obejmuje to takie aplikacje jak: gry wideo wspomagane przez AI czy filtry antyspamowe. Zdecydowana większość systemów AI używanych obecnie na terenie UE należy do tej właśnie kategorii.