Czerwiec nie zostawił złudzeń – kto nie stawia dziś na AI, ten wypada z wyścigu. Sztuczna inteligencja dyktuje tempo innowacji, niezależnie od tego, czy chodzi o chipy, sieci, oprogramowanie czy… rynek pracy. Najwięksi gracze nie zwalniają: NVIDIA znowu najdroższa spółką na świecie, AMD rozpycha się w centrach danych, Google pokazuje, jak AI może przejąć codzienne obowiązki biurowe, a Anthropic, Microsoft czy Dell robią wszystko, by nie zostać z tyłu.

Ale to dopiero początek. W tym podsumowaniu zebraliśmy dla Ciebie najważniejsze ogłoszenia, które naprawdę mają znaczenie dla świata IT PRO. Od nowych superkomputerów i kart sieciowych, przez przełomy w komputerach kwantowych, po zmiany w organizacji pracy, które AI przynosi szybciej, niż wielu się spodziewało.

Kwantowy wyścig nabiera tempa – czas na poważnie traktować nową erę obliczeń

Choć dziś to sztuczna inteligencja zgarnia całą uwagę, to tuż obok – trochę w cieniu – rozwija się rewolucja, która może równie mocno zmienić świat technologii. Komputery kwantowe coraz śmielej wchodzą do gry i zaczynają znajdować swoje miejsce w realnych zastosowaniach biznesowych. Czerwiec przyniósł wiele ważnych wieści z tej branży.

Na pierwszy plan wysuwa się IonQ, które ogłosiło przejęcie brytyjskiego startupu Oxford Ionics. Wartość transakcji? Ponad miliard dolarów. To największy zakup w historii firm rozwijających technologię kwantową. To jasny znak, że metoda oparta na pułapkach jonowych dostała potężne wsparcie – finansowe i organizacyjne. IonQ deklaruje, że do 2026 roku ich komputery osiągną 256 fizycznych kubitów, a docelowo mają sięgnąć milionów.

Równolegle IBM przedstawił plany stworzenia superkomputera kwantowego Quantum Starling. Urządzenie ma mieć 200 logicznych kubitów i wyróżniać się odpornością na błędy coś, co dziś stanowi jedno z największych wyzwań w tej technologii. Premiera planowana jest na 2029 rok, ale najważniejsze, że plan działań już istnieje i projekt jest w trakcie realizacji. IBM wyraźnie pokazuje, że jego ambicje sięgają daleko poza laboratoria – firma myśli o zastosowaniach w realnym biznesie.

Jeśli jednak ktoś nadal sądzi, że komputery kwantowe to temat przyszłości, D-Wave ma gotową odpowiedź. Ich nowa maszyna – Advantage2. już trafiła na rynek. Oferuje ponad 4400 kubitów i może działać zarówno w chmurze, jak i na miejscu, lokalnie. To nie jest obietnica, to działający produkt gotowy do wdrożenia, np. w zadaniach optymalizacyjnych czy przetwarzaniu złożonych modeli.

Warto zapamiętać: nie każdy kubit działa tak samo. Kubit to odpowiednik klasycznego bitu, ale w świecie mechaniki kwantowej, może istnieć w stanie 0 i 1 jednocześnie dzięki zjawisku superpozycji. Większa liczba kubitów oznacza potencjalnie większą moc obliczeniową, która teoretycznie rośnie wykładniczo. Ale sama liczba to nie wszystko, znaczenie ma też to, w jakiej technologii dany system powstał i do jakich zadań został zaprojektowany. Przykład? Komputery kwantowe D-Wave świetnie radzą sobie z problemami optymalizacyjnymi, podczas gdy maszyny IBM są stworzone do szerszego spektrum zastosowań, dzięki temu że można je zaprogramować, przypominają w działaniu klasyczne procesory.

Na tym tle pojawia się również polski akcent. W czerwcu w Poznaniu oficjalnie uruchomiono pierwszy europejski komputer kwantowy PIAST-Q, bazujący – podobnie jak maszyny IonQ – na technologii pułapek jonowych. To część unijnego projektu EuroHPC, którego celem jest budowa niezależnej infrastruktury obliczeniowej na Starym Kontynencie. Maszyna już działa, a jej zasoby będą dostępne dla firm technologicznych i instytucji badawczych.

Choć kwantowe komputery jeszcze nie weszły do powszechnego użytku, wiele wskazuje na to, że już za kilka lat staną się kluczowym elementem infrastruktury IT – szczególnie tam, gdzie liczy się maksymalna moc obliczeniowa. Dlatego warto już teraz przyglądać się tej technologii uważnie.

NVIDIA znów na szczycie – technologia AI wynosi ją na piedestał

Rozwiązania oparte na sztucznej inteligencji przestały być tylko wizją przyszłości – dziś są realnym narzędziem dla biznesu, gotowym do wdrożenia od zaraz. Ekosystem produktów i usług AI rośnie w imponującym tempie, a coraz więcej firm oferuje technologie, które można zastosować tu i teraz – bez fazy testów, oczekiwań czy pobożnych życzeń.

I właśnie w takim momencie NVIDIA wraca na pozycję lidera, zostając najbardziej wartościową firmą notowaną na giełdzie na całym świecie. W czerwcu jej kapitalizacja osiągnęła około 3,77 biliona dolarów amerykańskich, wyprzedzając technologicznych gigantów: Microsoft i Apple. Wszystko to dzięki ogromnemu zapotrzebowaniu na rozwiązania AI oraz niezachwianej pozycji firmy w sektorze centrów danych.

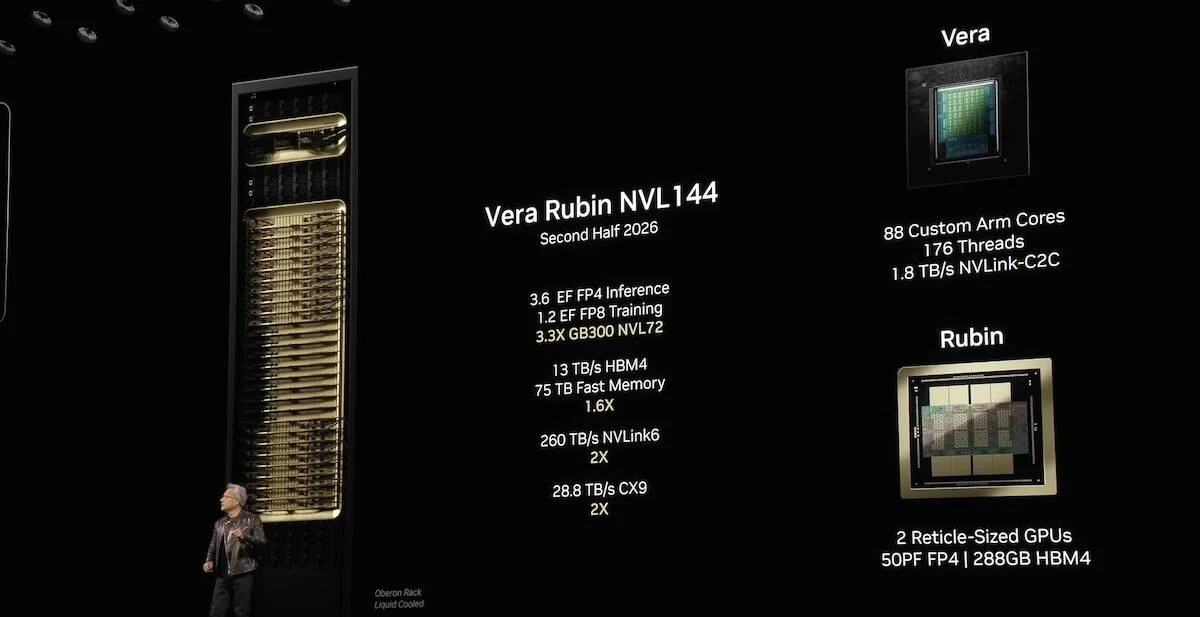

Ale sukces NVIDIA to nie tylko liczby. Firma ogłosiła realizację projektu superkomputera o nazwie Blue Lion, tworzonego wspólnie z HPE i niemieckim Leibniz Supercomputing Centre. Ten potężny system obliczeniowy będzie bazować na nowych procesorach Vera Rubin, co tylko potwierdza, że NVIDIA nie ogranicza się do produkcji kart graficznych – rozwija pełne środowisko obliczeniowe dla AI i high performance computing (HPC).

Co więcej, według doniesień agencji Reuters oraz magazynu Barron’s, inwestorzy patrzą na NVIDIĘ bardzo przychylnie. Głównie za sprawą planów wprowadzenia nowych układów: Blackwell Ultra, Rubin oraz Rubin Ultra. Mają one jeszcze bardziej przyspieszyć rozwój sztucznej inteligencji i umocnić technologiczną przewagę firmy. Analitycy z Loop Capital poszli o krok dalej – podnieśli prognozowaną cenę akcji NVIDIA do poziomu 250 USD, co w przyszłości mogłoby oznaczać wycenę rynkową sięgającą nawet 6 bilionów dolarów.

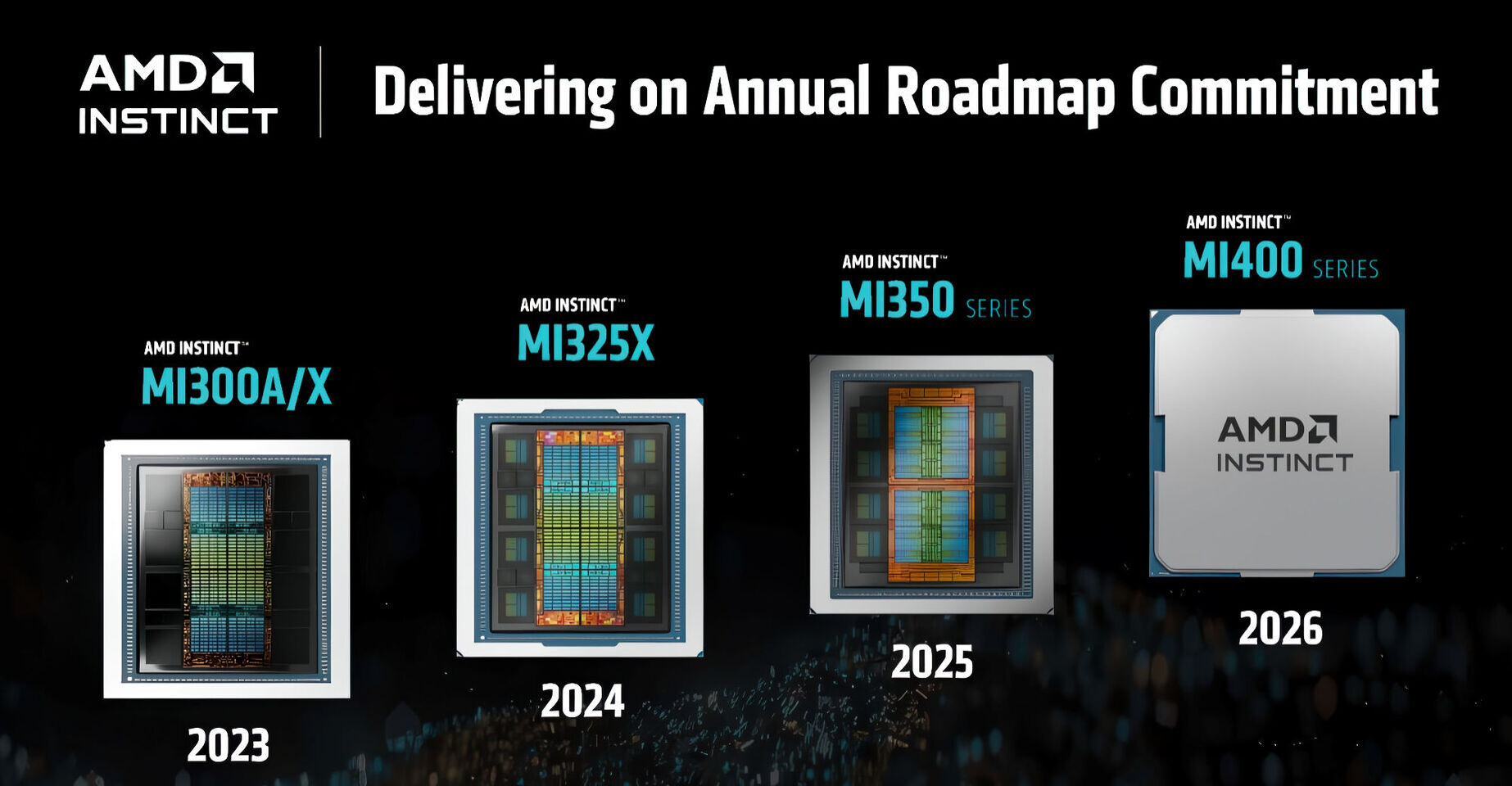

AMD poszerza horyzonty: od kart graficznych po sieci i superkomputery

Czerwiec przyniósł jasny sygnał: AMD nie zamierza ograniczać się wyłącznie do rynku CPU i GPU. Firma zaprezentowała swoją pierwszą kartę sieciową Pensando Pollara 400 GbE, zgodną z debiutującym standardem Ultra Ethernet Consortium (UEC) 1.0. To przełomowy moment, do tej pory najszybsze rozwiązania sieciowe w centrach danych były domeną NVIDII (dzięki Mellanoxowi) i Intela. Teraz AMD wchodzi do gry z ambicją zdobycia udziałów w rynku infrastruktury AI.

To jednak dopiero początek ofensywy. W zapowiedziach AMD znalazła się już kolejna karta – model „Vulcano” obsługujący 800 GbE, którego premiera planowana jest na 2026 rok. Co ciekawe, firma Oracle już potwierdziła wykorzystanie kart AMD w swoich klastrach AI, uzupełniając je akceleratorami Instinct MI350X, które również zadebiutowały w czerwcu.

Na tym nie koniec. AMD zapowiedziało też nadchodzącą generację układów z serii Instinct MI400. Wstępne informacje robią wrażenie: układy te mają oferować aż 432 GB pamięci HBM4 i ponad 40 PFLOPS mocy obliczeniowej w FP4, co plasuje je w bezpośredniej konkurencji z najmocniejszymi rozwiązaniami NVIDII. W połączeniu z procesorami EPYC Zen 6 oraz otwartą architekturą UALink, AMD konsekwentnie buduje własny, kompletny ekosystem do obliczeń AI i HPC – i wygląda na to, że może nieźle namieszać w tym segmencie.

Dlaczego to tak ważne? Współczesne centra danych nastawione na AI coraz częściej wymagają ultraszybkich połączeń sieciowych – zwłaszcza przy łączeniu dziesiątek lub setek GPU i akceleratorów w jeden system. Modele językowe liczące miliardy parametrów potrzebują nie tylko ogromnej mocy obliczeniowej, ale też ekspresowego transferu danych między węzłami. Technologie 400 i 800 GbE przekładają się nie tylko na większą przepustowość, ale również niższe opóźnienia, lepszą synchronizację treningu modeli oraz mniejsze obciążenie CPU.

Dla firm budujących własne klastry AI – niezależnie od tego, czy zajmują się przetwarzaniem danych, czy rozwijają duże modele językowe – to szansa na większą wydajność bez konieczności wiązania się z jednym dostawcą infrastruktury.A dla AMD? To strategiczny krok w kierunku zajęcia niszy, którą przez lata niemal w całości kontrolowała NVIDIA.

AI na sterach: Google wprowadza nową erę automatyzacji pracy

Podczas konferencji Google I/O 2025 firma z Mountain View zarysowała jasny kierunek. Sztuczna inteligencja ma nie tylko wspierać, ale samodzielnie realizować zadania. Największe zainteresowanie wzbudził Agent Mode w ramach aplikacji Gemini, działający w oparciu o projekt Mariner. Nowa funkcjonalność pozwala użytkownikowi zlecić kompletny proces AI, na przykład polecając: „stwórz prezentację na podstawie ostatniego spotkania i wyślij ją zespołowi”. Sztuczna inteligencja sama analizuje dokumenty, zbiera dane, tworzy prezentację, a następnie rozsyła ją we właściwej formie do odpowiednich osób.

Co więcej, Gemini potrafi „uczyć się” rutynowych czynności już po jednym pokazie – funkcja teach & repeat, a także obsługiwać do dziesięciu zadań jednocześnie. Choć pełnia możliwości jeszcze nie jest dostępna, Google zapowiada jej premierę do końca bieżącego roku.

To duży krok naprzód dla środowisk biznesowych – mniej ręcznego klikania, więcej automatyzacji, zwłaszcza w ramach pakietu Google Workspace. Co istotne, Google nie zamierza ograniczać nowego rozwiązania tylko do własnych narzędzi – zapowiedziano również udostępnienie otwartego API. Dzięki temu możliwa będzie integracja z zewnętrznymi systemami, takimi jak CRM, ERP czy platformy do automatyzacji procesów.

Z kolei samo Gemini – wzmocnione przez rozwiązania Magnum I/O – zyskało nowe możliwości. Wersje Gemini 2.5 Pro i Gemini Flash wyposażono w tryb Deep Think, przeznaczony do rozwiązywania bardziej skomplikowanych problemów, oraz wsparcie dla multimodalności, czyli jednoczesnej pracy z tekstem, obrazem i dźwiękiem. Google nie zapomniało też o aspektach związanych z kontrolą i bezpieczeństwem – wprowadzono tzw. budżety tokenów, które działają jak limit zasobów przetwarzanych przez AI podczas jednego zadania. To rozwiązanie zwiększa przewidywalność i transparentność działania, szczególnie w środowiskach firmowych.

Drugim istotnym punktem konferencji była premiera nowej wersji NotebookLM, narzędzia AI do pracy z dokumentami, które teraz zachowuje się jak inteligentny analityk. Użytkownik może załadować pliki, notatki czy prezentacje, a aplikacja sama zaproponuje podsumowania, analizy lub ułatwi generowanie nowych treści. Co ważne, NotebookLM działa lokalnie, umożliwiając pełną kontrolę nad danymi i integrację z firmowymi repozytoriami.

Google jasno komunikuje: sztuczna inteligencja nie ma być tylko doradcą, ale pełnoprawnym wykonawcą zadań. A jeśli konkurencja podąży tą samą ścieżką, możemy być świadkami przełomu w tym, jak wygląda codzienna praca w firmach.

Wyścig po AI: Google nie jest już samotnym liderem

Choć to Google najczęściej pojawia się na pierwszym planie, jeśli chodzi o rozwój sztucznej inteligencji, inne firmy zdecydowanie nie pozostają w tyle. Czerwiec obfitował w ważne zapowiedzi od graczy, którzy realnie wprowadzają AI do codziennych zastosowań biznesowych – od automatyzacji pracy, przez przetwarzanie danych, aż po tworzenie spersonalizowanych modeli wewnętrznych.

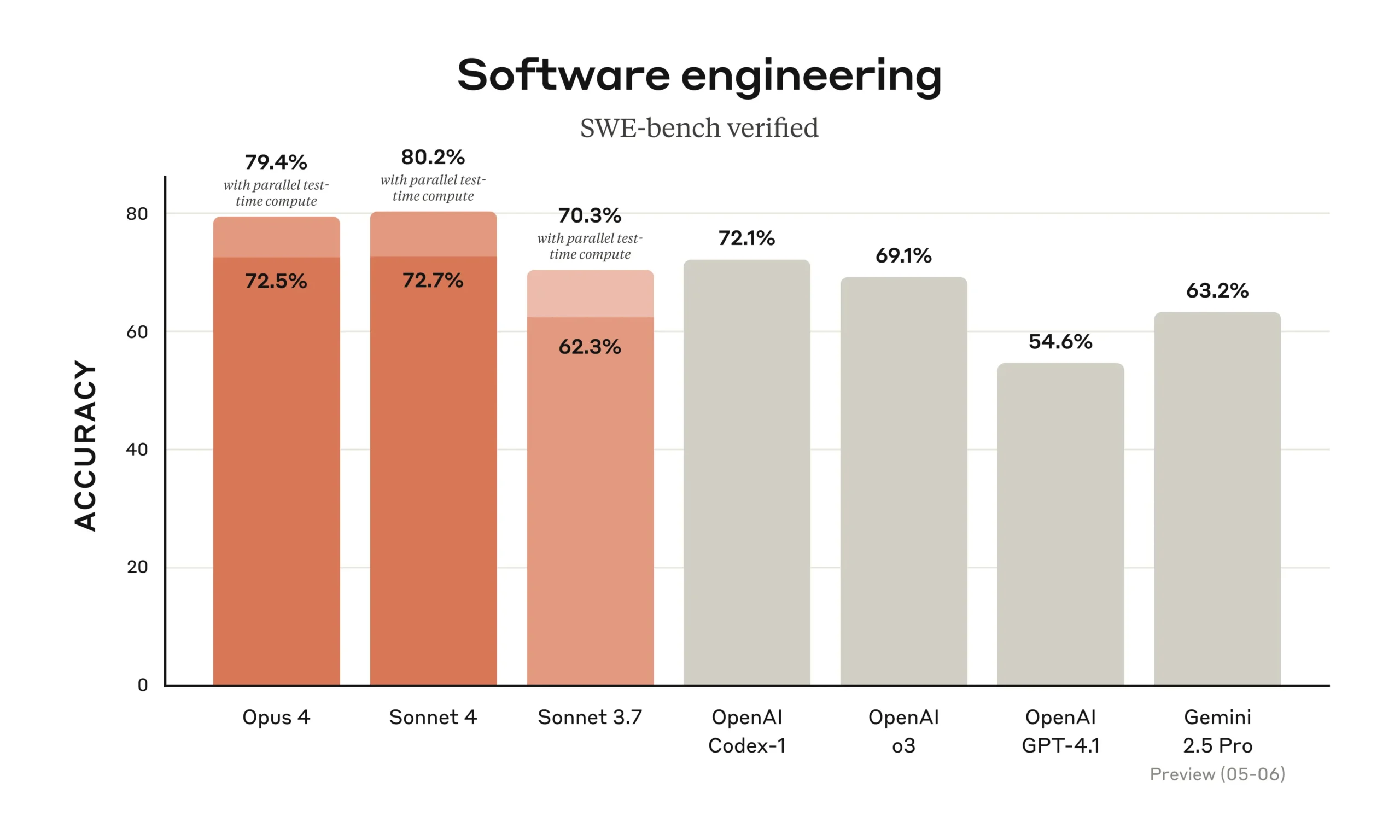

Na pierwszy ogień idzie Anthropic, które oficjalnie zaprezentowało model Claude 4. To rozwiązanie, które potrafi nie tylko zrozumieć wyjątkowo złożone pytania, ale również samodzielnie realizować zadania przez dłuższy czas, od kilku minut po nawet godziny. I to bez konieczności ciągłego nadzorowania. Claude świetnie sprawdza się m.in. przy analizie danych, generowaniu raportów czy streszczaniu rozbudowanych dokumentów, działając niemal jak wirtualny asystent biurowy. Dodatkowo stworzono go z myślą o bezpieczeństwie i stabilności w środowiskach korporacyjnych.

Microsoft nie pozostaje w tyle. Firma ogłosiła, że już 100 tysięcy jej pracowników zostało przeszkolonych w korzystaniu z Copilotów bazujących na GPT. To jasny sygnał, jak szybko narzędzia AI trafiają do codziennej pracy biurowej i analitycznej. Równocześnie na rynku pojawiło się nowe rozwiązanie od europejskiej firmy Mistral AI Enterprise Copilot. To system działający lokalnie, bez konieczności korzystania z chmury, zapewniający pełną prywatność danych – rozwiązanie stworzone z myślą o firmach z restrykcyjną polityką bezpieczeństwa.

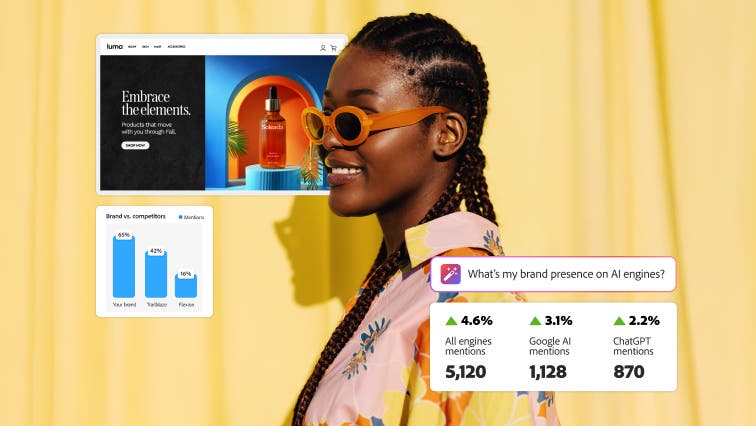

Swój ruch wykonało też Adobe, które zaprezentowało LLM Optimizer . Nowe narzędzie stworzone z myślą o firmach, które chcą lepiej kontrolować widoczność swoich treści w generatywnych wyszukiwarkach i odpowiedziach modeli takich jak ChatGPT, Claude czy Gemini. System umożliwia m.in. analizę ruchu pochodzącego z AI, porównywanie obecności marki z konkurencją, a także generowanie i wdrażanie rekomendacji SEO z poziomu Adobe Experience Manager. Według danych Adobe, tylko w ciągu ostatniego roku ruch z AI-asystentów na stronach e-commerce wzrósł o 3500%, co pokazuje, jak duże znaczenie ma dziś optymalizacja treści pod kątem generatywnych modeli.

Warto zwrócić uwagę także na inicjatywę Dell Technologies, które postanowiło połączyć siły sprzętu i oprogramowania, oferując gotowe zestawy AI dla biznesu. AI Factory od Della to prefabrykowane, modułowe centra obliczeniowe. Kompletne systemy gotowe do wdrożenia w dużych organizacjach bez konieczności budowania wszystkiego od podstaw. Dla wielu firm to może być prawdziwy przełom.

Na koniec coś, co może niebawem wstrząsnąć branżą. Według nieoficjalnych doniesień Apple rozważa zakup Perplexity AI, konkurenta Google w dziedzinie asystentów opartych na AI. Jeśli do przejęcia rzeczywiście dojdzie, Apple może znacząco wzmocnić swoją pozycję na rynku biznesowych rozwiązań generatywnej AI – zwłaszcza tych funkcjonujących w środowiskach zamkniętych i lokalnych.

AI nie tylko wspiera – zaczyna rządzić rynkiem pracy

Sztuczna inteligencja przestaje być tylko „inteligentnym asystentem” – coraz częściej to ona bierze na siebie kluczowe zadania w firmach. I przedsiębiorstwa nie mają z tym problemu – wręcz przeciwnie, mówią o tym otwarcie. Amazon ogłosił, że automatyzacja oparta na AI wpłynie na zmniejszenie liczby stanowisk biurowych. Z kolei Salesforce, dzięki wzrostowi efektywności pracy napędzanemu przez AI, przesunął 500 pracowników z działu obsługi klienta do innych zadań – oszczędzając przy tym około 50 milionów dolarów. Co istotne, zmiany nie wynikały z cięć, a z większej produktywności.

To nie tylko luźne deklaracje – mamy na to liczby i prognozy. Według globalnego raportu Bitrix24 „Przyszłość pracy w 2050 roku”, sztuczna inteligencja już w najbliższych dekadach przejmie większość procesów związanych z rekrutacją: od analizy CV, przez rozmowy kwalifikacyjne, po onboarding. Eksperci przewidują też, że większość spotkań firmowych będzie odbywać się w środowiskach wirtualnych, a tradycyjne biura staną się rzadkością. To wszystko oznacza fundamentalną zmianę w organizacji pracy, zarówno strukturalnie, jak i kulturowo.

Dla działów HR i osób zarządzających zespołami to jasny sygnał – jeśli nie zaczną wdrażać automatyzacji już dziś, mogą szybko zostać w tyle. Bo przyszłość współpracy, zatrudniania i adaptacji pracowników będzie zależeć od tego, jak dobrze firma potrafi zintegrować AI ze swoimi procesami.A jeśli czerwiec był tylko przedsmakiem tego, co przyniesie druga połowa 2025 roku, to zapowiada się naprawdę intensywny czas w świecie nowych technologii.