Według najnowszego raportu udostępnionego przez TrendForce wynika, że branża rozwiązań dla profesjonalistów została zdominowana przez układy wyposażone w pamięć typu HBM. Jak możemy przeczytać w raporcie również następne generacje akceleratorów, będą korzystać z tego typu moduły następnej generacji.

Czyżby na rynku nie było innych alternatyw? Przecież moduły HBM nie należą do najtańszych, wiec nasuwa się pytanie, czemu zyskują aż taką popularność?

Pamięć HBM, co to właściwie znaczy

Jednak zacznijmy standardowo od podstaw. Co to właściwie jest HBM. W dużym uproszczeniu jest to rodzaj pamięci stosowanej na kartach graficznych, akceleratorach obliczeniowych czy modułach pamięci dla nowoczesnych procesorów. Technologia HBM (High Bandwidth Memory) została opracowana jako odpowiedź na rosnące wymagania w zakresie wydajności, zwłaszcza w zaawansowanych aplikacjach związanych z grafiką komputerową, sztuczną inteligencją, głębokim uczeniem, superkomputerami i rozwiązaniami w chmurze. Czemu?

Moduły HBM charakteryzują się dużo wyższą przepustowością, dzięki czemu umożliwiają bardzo szybki transfer danych między pamięcią a układem obliczeniowym. Dodatkowo systemy wyposażone w ten rodzaj pamięci mają zauważalnie niższe opóźnienia. Wszystko to wpływa na zauważalne przyspieszenie działania jednostki obliczeniowej.

Dodatkowo pamięć HBM została zaprojektowana tak, by moc wykorzystywać szeroką magistralę komunikacyjną. Dzięki temu możliwe jest jednoczesne transfer wielu danych w tym samym czasie. Kolejną zaletą jest wykorzystanie rozwiązań znanych z modułów 3D V-nand. Tak pamięć HBM jest zintegrowana w stosach, co oznacza, że układy pamięci są ułożone na sobie w trójwymiarowym układzie. Pomaga to zminimalizować długość ścieżek komunikacyjnych, dzięki temu właśnie uzyskano redukcje opóźnień.

Mimo dużo wyższej wydajności moduły HBM mogą pochwalić się lepszą efektywnością energetyczną. Oznacza to, że akceleratory wyposażone w tę pamięć nie tylko będą pobierać mniej prądu, ale co najważniejsze wydzielać mniej ciepła co w rozwiązaniach profesjonalnych ma największe znaczenie.

I choć obecnie stosuje się ją wyłącznie w zastosowaniach “Pro”, to przed kilkoma laty dostępny były karty graficzne wyposażone moduły HBM. Oczywiście mowa tutaj o Radeonach R9 z rodziny Fury czy VEGA oraz Titan V.

Wydajność kosztem ceny

Mimo wszystkich tych zalet największą wadą stosowania HBM wydaje się cena. Nie mam tutaj na myśli wyłącznie kosztów samych modułów. Zmiana typu pamięci powoduje konieczność przeprojektowania zarówno całego rdzenia obliczeniowego, jak i płytki PCB. Czemu?

Cóż jak już wspominałem moduły HBM korzystają z szerokiej magistrali. W przeciwieństwie do kart graficznych, które znajdziemy w naszych komputerach, nie mówimy w tym wypadku o setkach bitów, ale o tysiącach. Przeważnie producenci decydują się na zastosowanie 4096 bitowej szyny wymiany danych, choć znajdziemy na rynku konstrukcje z jeszcze szybszą magistralą. Oznacza to nawet 10 razy więcej połączeń pomiędzy samymi pamięciami a rdzeniem obliczeniowym.

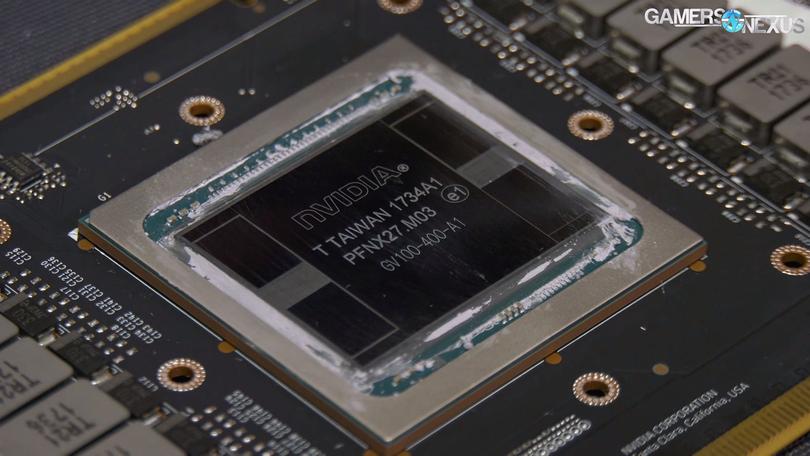

Dodatkowo moduły HBM z racji na niższe napięcie zasilania muszą być umieszczanie znacznie bliżej układu. W innym przypadku sygnał, przez który są przesyłane dane, byłby narażony na utratę spójności, co mogłoby doprowadzić do powstania licznych błędów. Z tego względu właśnie kości HBM zostają umieszczone tuż obok rdzenia, będąc z nim niemal zespolone. Na pierwszy rzut oka wygląda to identycznie jak w konstrukcji chipletowej układów AMD stosowanych w kartach Radeon RX 7900.

Niestety, bez szczegółowych danych, którymi producenci się nie chwalą, trudno zgadnąć, jak bardzo te zmiany wpływają na koszty budowy akceleratorów. Znamy natomiast ich finalne ceny. Jeżeli myślicie, że RTX 4090 jest drogi, to czeka was niemiła niespodzianka. Najnowsze jednostki NVIDII H100 mają kosztować ponad 20000 dolarów (tak dwadzieścia tysięcy) za sztukę. Dodatkowo zalecana konfiguracja serwera AI powinna być wyposażona aż w 8 takich akceleratorów.

Nadchodzi HBM3, HBM3e i HBM4

Wróćmy do wspomnianego raportu TrendForce. Dowiadujemy się z niego, że nadchodzące akceleratory od AMD, jak i od NVIDII będą korzystały z nowego typu pamięci HBM3. Tak, zarówno w produktach serii H100 i H800 od NVIDII, jak i AMD MI300 znajdziemy moduły nowej generacji.

Ten mają być dostępne w dwóch wariantach, a podział ma być zależny od ich prędkości. Niestety jak to bywa w branży IT, każdy z producentów stosuje swoje nazewnictwo. Tak więc podstawowe moduły HBM3 mają działać z prędkością od 5,6 do 6,4 Gb/s. Dużo szybsze mają być jednostki HBM3e, zwane tez HBM3P, HBM3A, HBM3+ i HBM3 Gen2. Mają one pozwolić na przekroczenie nawet 8Gb/s.

Oczywiście spodziewać się też możemy wzrostu pojemności samych modułów. Nowością mają być kości o pojemności 24 GB składające się z 8 warstw. Przewiduje się, że to właśnie ta pamięć trafi na zaplanowanego na 2025 rok układu Broodwell (GB100) od NVIDII.

Wiemy również że zarówno SK Hynix, jak i Micron pracują nad kolejną generacją HBM4. Jednak ta trafi na rynek najszybciej dopiero w 2026 roku. Żadna z firm nie zdecydowała się również na prezentację wstępnych parametrów.

Nie tylko AMD i NVIDIA stawiają na HBM

Zagłębiając się dalej w raport TrendForce zauważymy, że nie tylko dwaj znani producenci akceleratorów skupiają swoją uwagę na pamięci HBM3. Coraz częściej wspomina się, że najwięksi dostawcy usług w chmurze (Cloud Solution Provider, CPS), zaczynają sami tworzyć akceleratory AI nowej generacji, dostosowane do ich własnych potrzeb. Biorąc pod uwagę, wspomniane wcześniej, ceny jednostek NVIDII, nie ma co się dziwić.

Wszytko, wskazuje, że Tensor Processing Unit od Googla, czy AWS Trainium i Inferentia od Amazonu, w nowej wersji również będzie wykorzystywała pamięć HBM3. Zapewne śladem tych firm podąża kolejne firmy z branży.

Brak konkurencji dla HBM

Biorąc pod uwagę duże ilości danych przetwarzane przez akceleratory AI w centrach szkoleniowych sztucznej inteligencji, nie możemy się dziwić, że producenci układów zdecydowali się na tak szerokie zastosowanie modułów HBM. Te są po prostu bezkonkurencyjne.

| Typ pamięci | Magistrala (bit) | Prędkość modułów (Gb/s) | Przepustowość systemu pamięci (GB/s) |

|---|---|---|---|

| GDDR6 | 512 | 20 | 1280 |

| GDDR6W | 512 | 24 | 1536 |

| GDDR7 | 512 | 32 | 2048 |

| HBM2E | 4096 | 3,2 | 1638,4 |

| HBM3 | 4096 | 5,6 | 2867,2 |

| HBM3e | 4096 | 8 | 4096 |

Przy okazji omawiania pamięci GDDR7 wspomniałem co prawda o modułach GDDR6W. Te miałby, by być właśnie alternatywą dla kości HBM. Na pewno rozwiązanie Samsunga będzie zauważalnie tańsze, ale na tym jednak korzyści się kończą. Nawet przy zastosowaniu najszybszych modułów i 512 bitowej szyny danych, GDRR6W nie jest w stanie dogonić HBM2e. Zestawiając propozycje Samsunga z HBM3, zauważymy, że nowe moduły będą prawie dwukrotnie szybsze.

Nie ma zatem co się dziwić, że całą branżą rozwiązań dedykowanych sztucznej inteligencji, decyduje się na stosowanie modułów HBM. Pozostaje mieć nadzieje, że wzrost popularności pamięci przyczyni się z czasem do obniżenia jej ceny. Być może wtedy doczekalibyśmy się ponownie konstrukcji dla szerszej grupy odbiorców wyposażonej w te szybkie kości.