AMD szykuje się do ofensywy na rynku rozwiązań AI i profesjonalnych procesorów, które już wkrótce mogą skutecznie konkurować z dominującym na rynku NVIDIĄ. Na Financial Analyst Day 2025 producent odsłonił plany na najbliższe lata, prezentując dwie kluczowe linie akceleratorów AI: Instinct MI400 oraz zapowiadaną na 2027 rok serię Instinct MI500. Obok tego AMD potwierdził rozwój nowej generacji procesorów Zen6 i Zen7, które wprowadzają istotne ulepszenia w wydajności i możliwościach AI.

Instinct MI400 – duży krok dla centrów danych i AI

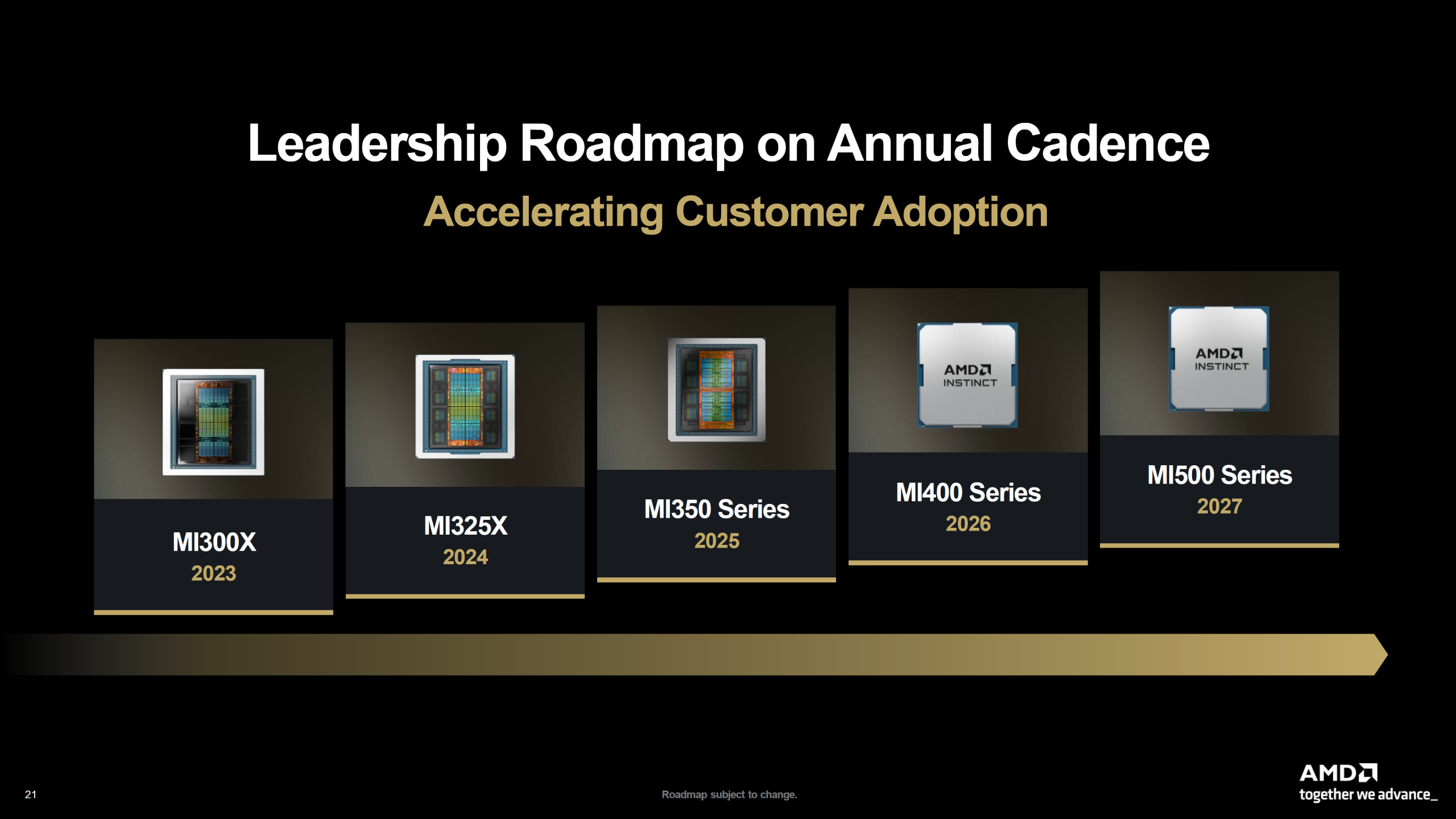

Po pierwsze, AMD przechodzi na „roczny cykl wydawniczy” dla swoich akceleratorów AI. To bezpośrednia odpowiedź na strategię NVIDII. Koniec z czekaniem! Co roku mamy dostać nowy, potężniejszy sprzęt do walki o wydajność w modelach językowych i obliczeniach naukowych.

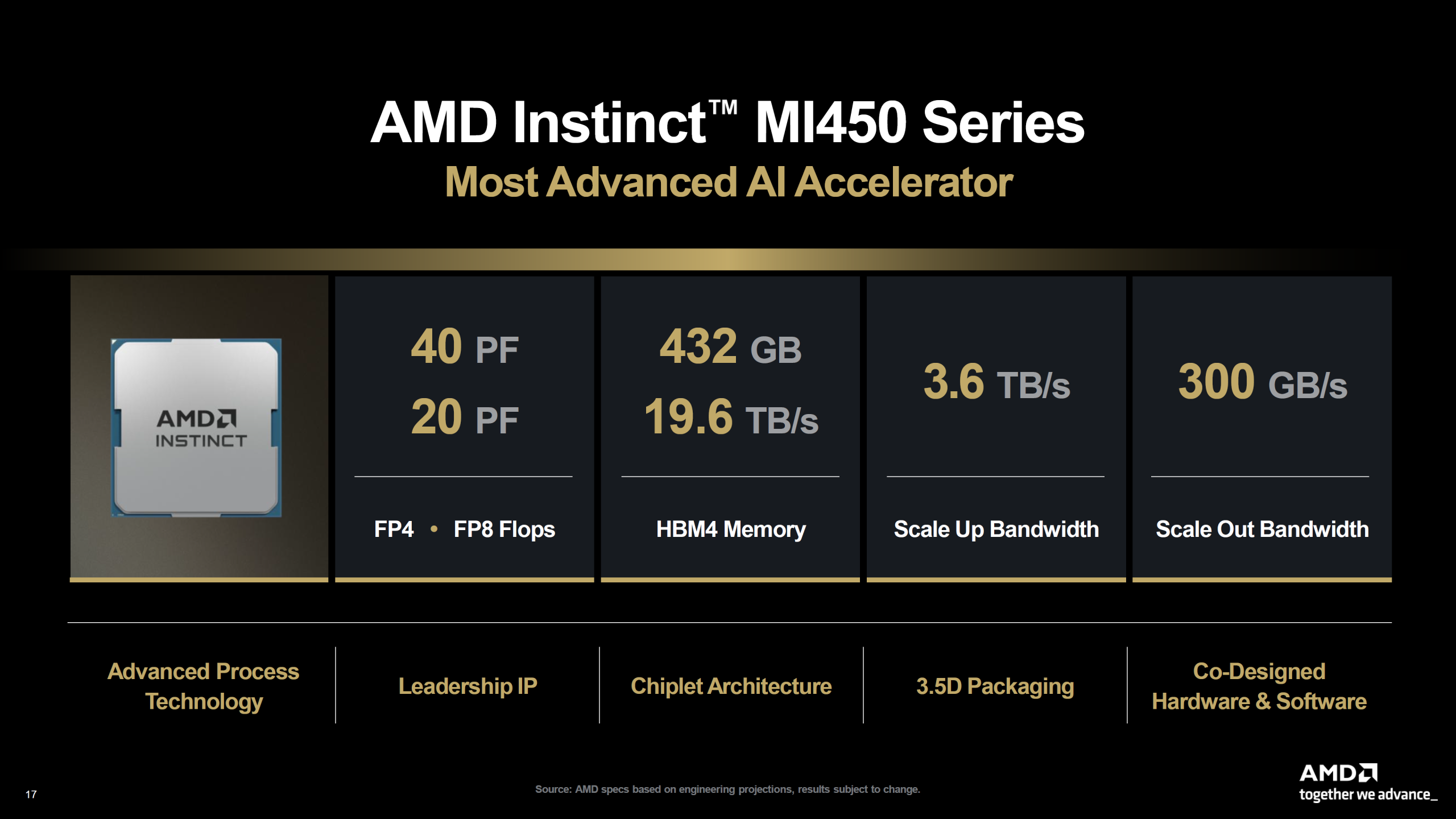

Sercem tej strategii ma być nadchodząca seria AMD Instinct MI400, planowana na 2026 rok. To ona ma stanąć w szranki z układami „Vera Rubin” od NVIDII. A specyfikacja robi wrażenie. Seria Instinct MI400 bazuje na nowej architekturze CDNA 5 i będzie wyposażona w pamięć HBM4 o przepustowości aż 19,6 TB/s, co niemal podwaja możliwości poprzednich modeli (HBM3e).

AMD zaoferuje akceleratory MI400 w dwóch wariantach. MI455X dostosowany dla wymagań treningu i inferencji AI oraz MI430X dedykowany HPC i AI obliczeniom wysokiej precyzji (FP64), a także z funkcjami hybrydowego przetwarzania CPU+GPU. Zgodnie z komunikatem AMD, MI400 podwaja moc obliczeniową względem serii MI350, osiągając 40 PFLOPów w formacie FP4 i 20 PFLOPów dla FP8. To realna odpowiedź na obecne liderowanie NVIDII, zwłaszcza modelu Vera Rubin, z wyraźnym wzmocnieniem pamięci i przepustowości połączeń sieciowych.

Kontynuując coroczny cykl premier, AMD wprowadzi w 2027 r. generację MI500, która ma przynieść równie duży skok zarówno w mocy obliczeniowej, jak i w możliwościach pamięci oraz łączności sieciowej. To rozwiązanie ma tworzyć szkielet następnej generacji centrów danych AI, oferując równolegle wersje standardowe i „Ultra”, co przypomina strategię rynkową NVIDII.

Zen 6 i Zen 7 – nowe procesory z myślą o AI i profesjonalistach

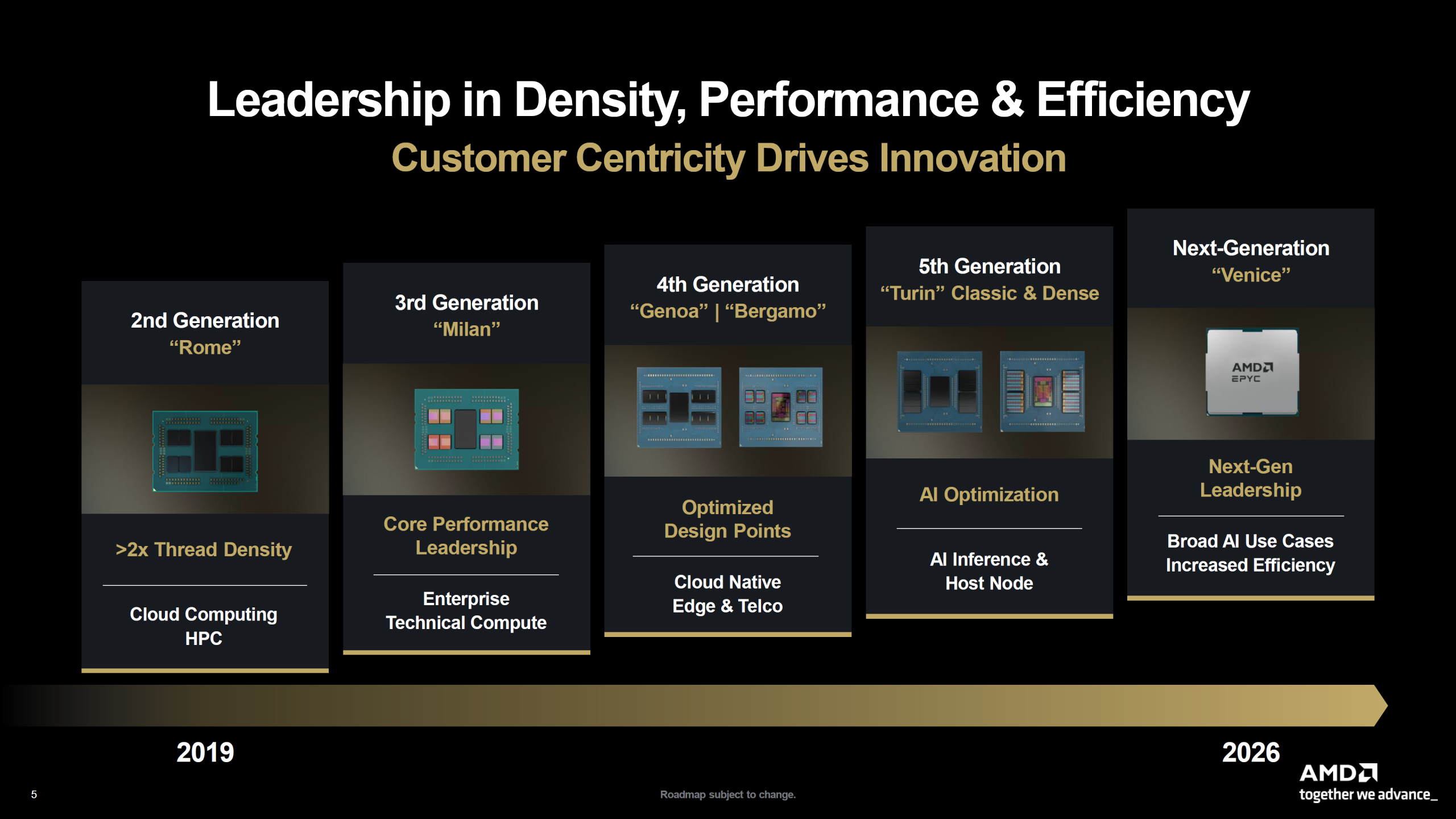

Jednak same akceleratory to nie wszystko. AMD doskonale wie, że systemy AI i HPC potrzebują też potężnych procesorów CPU. Tu do gry wchodzi architektura Zen. Firma potwierdziła istnienie nie tylko Zen 6 (premiera w 2026), ale także kolejnej generacjii Zen 7. Architektura Zen 6 (oparta na procesie TSMC 2nm) przyniesie dalszy wzrost wydajności i efektywności energetycznej. Będzie też fundamentem dla serwerowych procesorów EPYC „Venice”.

Prawdziwa rewolucja dla rynku AI szykuje się jednak w Zen 7 (2027-2028). Architektura ta, oprócz nowej technologii produkcji, wprowadzi coś, co AMD nazywa „Nowym Silnikiem Matrix” (New Matrix Engine) oraz wsparcie dla nowych formatów danych AI. Oznacza to, że sam procesor CPU dostanie wyspecjalizowane jednostki do obsługi zadań AI, co może drastycznie przyspieszyć wnioskowanie (inference) i mniejsze obciążenia, odciążając przy tym główne akceleratory GPU.

Helios i PCIe 7.0 – fundament nowoczesnej infrastruktury AI

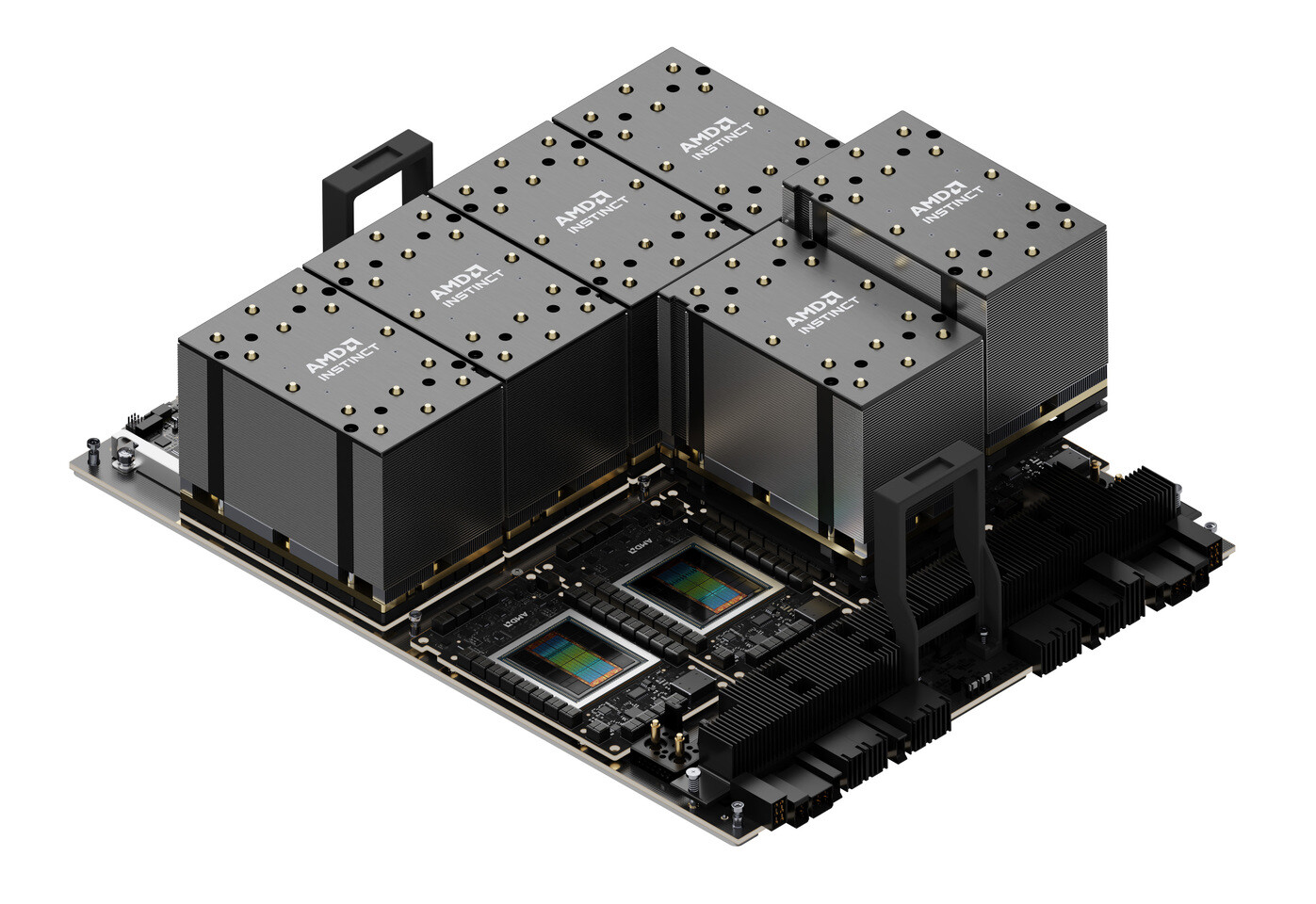

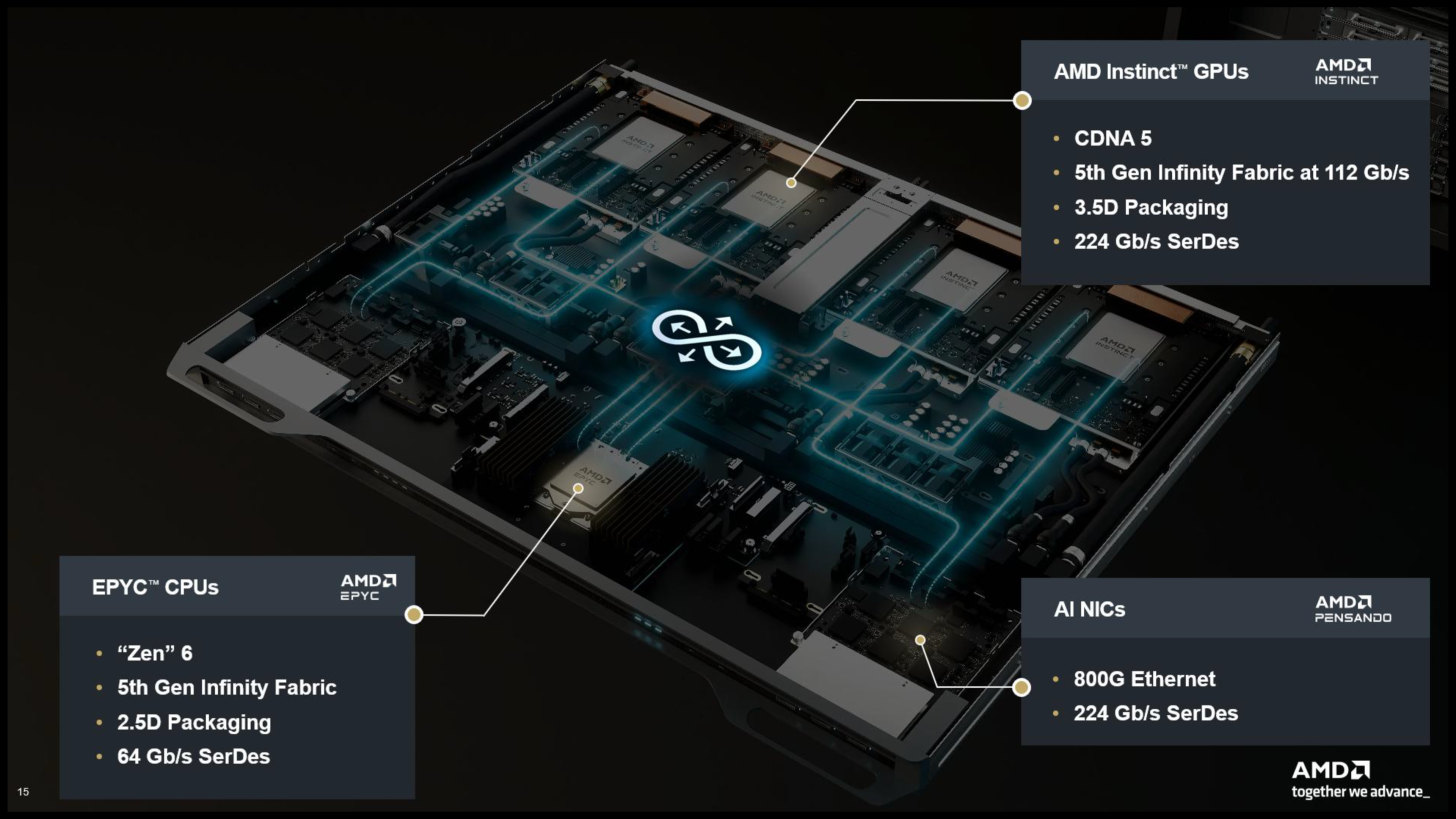

Dla architektów i administratorów IT kluczową innowacją jest platforma serwerowa Helios, która integruje procesory AMD Zen 6 (EPYC Venice) z akceleratorami AI Instinct MI400 opartymi na architekturze CDNA 5. Całość łączy piąta generacja magistrali Infinity Fabric oraz zaawansowane techniki pakowania w technologii 2.5D, co przekłada się na wyjątkową wydajność i skalowalność.

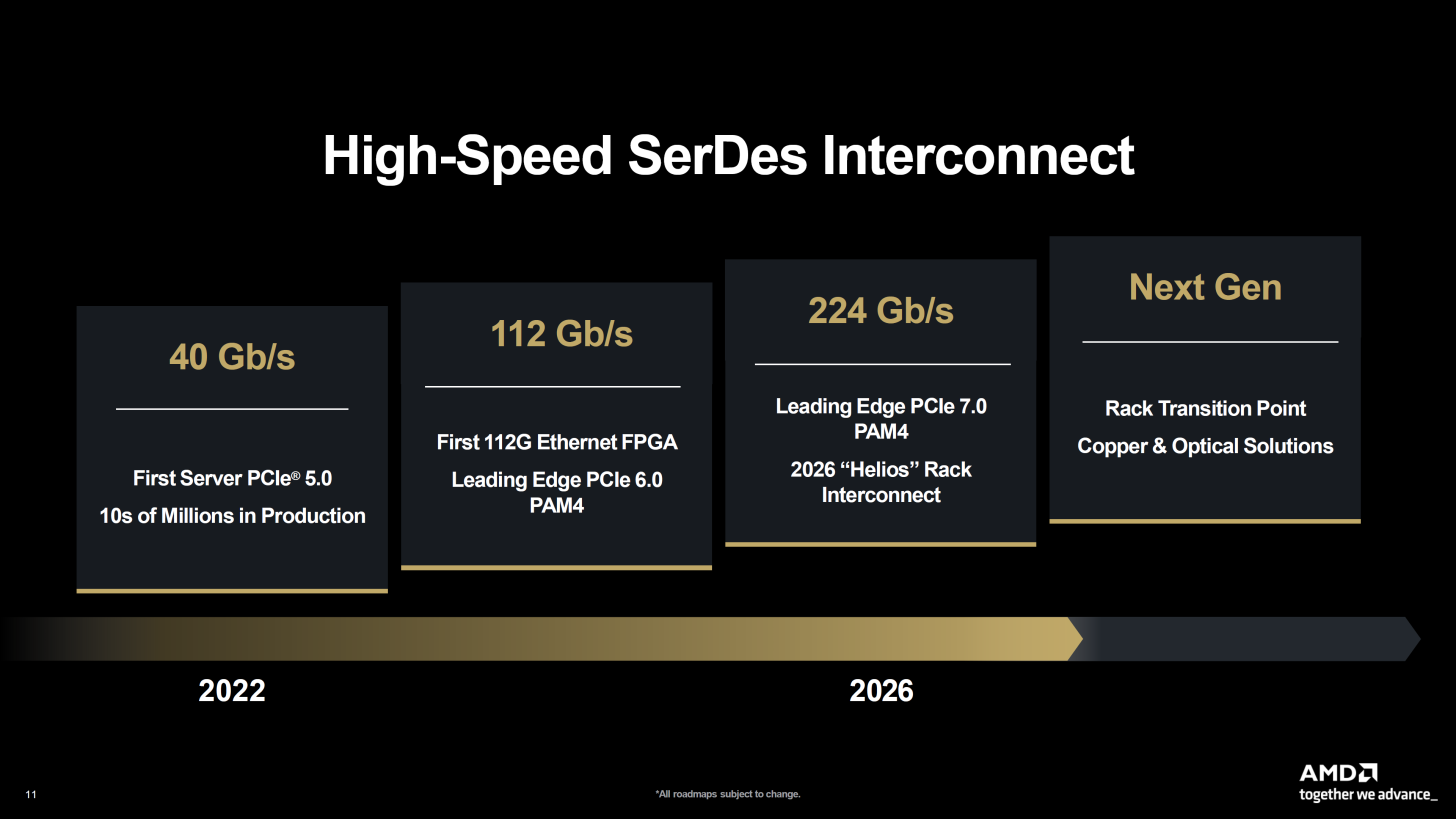

Najważniejszym elementem Heliosa jest otwarta architektura rack-scale, która umożliwia komunikację i współdzielenie zasobów w ramach jednej szafy serwerowej oraz między szafami. W tym celu AMD wspiera standardy takie jak UALink oraz najnowszy PCIe 7.0, zapewniający aż do 224 GB/s przepustowości między komponentami. Taka przepustowość eliminuje wąskie gardła i pozwala na efektywną pracę rozbudowanych konfiguracji AI i HPC.

Helios to nie tylko zestaw hardware’u, ale w pełni zintegrowany ekosystem serwerowy z myślą o wymagających środowiskach biznesowych i centrach danych. Zaawansowane chłodzenie cieczą z szybkozłączkami, podwójnie szeroka konstrukcja rack oraz otwarte standardy komunikacji sprawiają, że platforma jest przyszłościowym rozwiązaniem dla dużych implementacji AI, gdzie wydajność, elastyczność i łatwość serwisowania są kluczowe.