Nvidia prezentuje Rubin CPX – wyspecjalizowany akcelerator AI, który ma wprowadzić nowy standard w obsłudze dużych modeli AI. Kluczem do zmian jest odejście od kosztownej pamięci HBM na rzecz nowej generacji GDDR7, znacznie tańszej i bardziej energooszczędnej.

Do tej pory serwerowe GPU Nvidii uchodziły za złoty standard, ogromna wydajność, pamięć HBM3E, zaawansowane interkonekty i dopracowany ekosystem CUDA. Problem w tym, że wraz ze wzrostem popularności modeli LLM, takich jak GPT-5 czy Gemini 2, centra danych zaczynają mierzyć się z nieefektywnością kosztową. Flagowe akceleratory świetnie radzą sobie z generowaniem kolejnych tokenów, ale podczas fazy kontekstowej, gdy model musi „przeżuć” miliony tokenów wejściowych, okazują się przewymiarowane i zbyt drogie w eksploatacji.

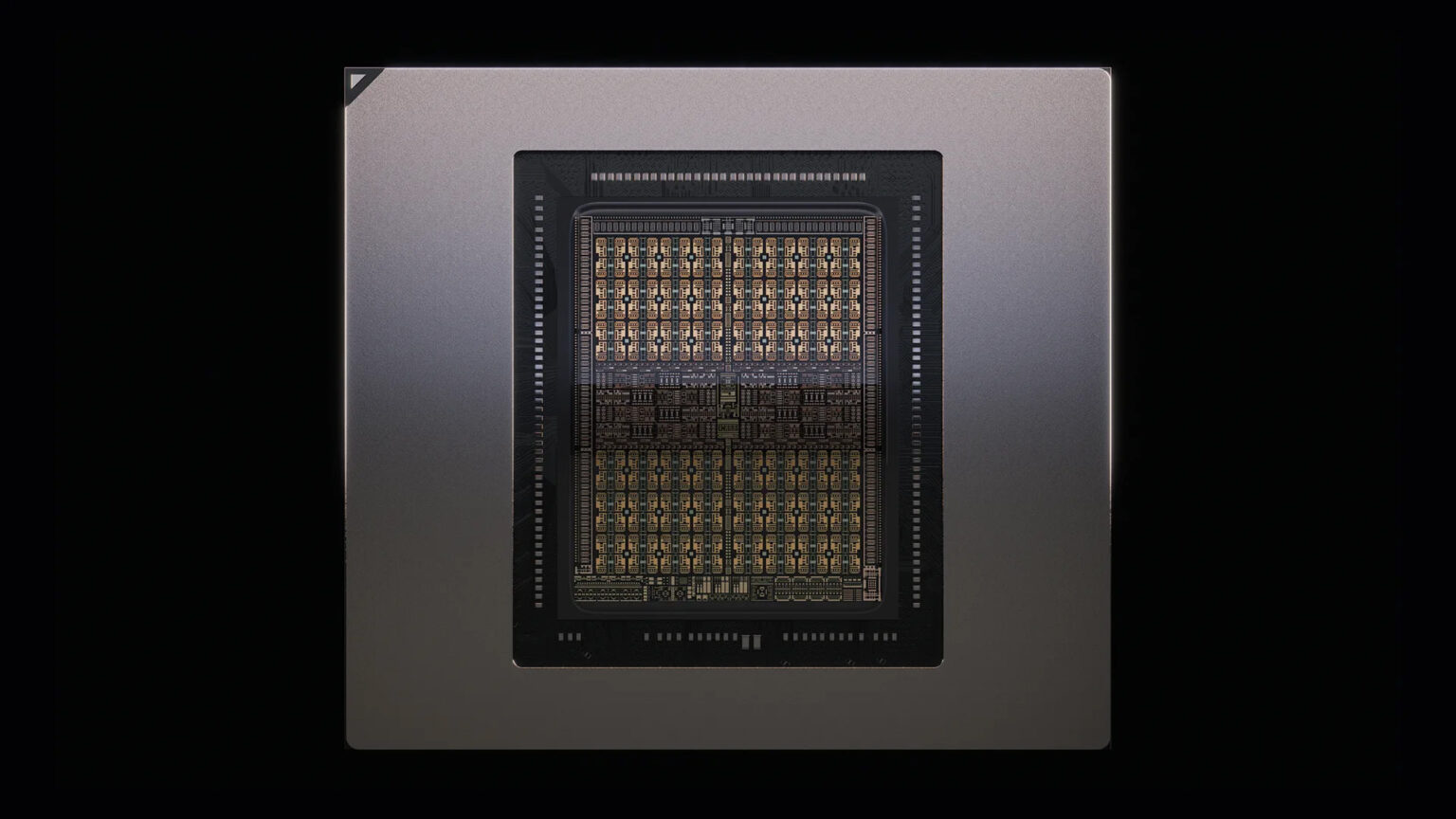

Tu wchodzi Rubin CPX (Content Phase aXcelerator). Nowy układ został zaprojektowany wyłącznie z myślą o obsłudze długich kontekstów wejściowych, czyli etapu, w którym LLM analizuje obszerne dokumenty, kody źródłowe czy dane multimedialne. CPX ma do dyspozycji aż 128 GB pamięci GDDR7, zamiast kosztownej HBM, co pozwala znacząco obniżyć cenę i zużycie energii. GDDR7, mimo niższej przepustowości, zapewnia wystarczającą wydajność, a przy tym jest prostsza w produkcji, nie wymaga drogich technologii pakowania (np. CoWoS) i eliminuje część wąskich gardeł w dostawach.

Nowa architektura NVIDII to tak zwany model rozdzielony. Układ Rubin R100 odpowiada za fazę generacji (wydajne HBM i ogromna przepustowość), a Rubin CPX, za fazę kontekstową. Oprogramowanie Dynamo automatycznie przydzieli obciążenia do odpowiedniego układu, co w praktyce ma oznaczać niższy całkowity koszt posiadania (TCO) i efektywniejsze wykorzystanie zasobów w hiperskalowych centrach danych.

Nvidia szacuje, że inwestycja w platformę CPX może zwrócić się operatorom kilkudziesięciokrotnie – przy nakładach rzędu 100 mln dolarów potencjalne przychody z usług inference mogą sięgnąć nawet 5 mld. Dla rynku AI to jasny sygnał: nie tylko moc obliczeniowa, ale i ekonomia infrastruktury staje się kluczowa w nadchodzących latach.