Gdy świat wciąż zachwyca się architekturą Blackwell, inżynierowie z Santa Clara są już o dwie generacje dalej. Nvidia właśnie uchyliła rąbka tajemnicy na temat platformy Vera Rubin. I nie mówimy tu o kolejnej iteracji specyfikacji. Mówimy o systemie tak złożonym i prądożernym, że działy utrzymania infrastruktury w hyperscalerach będą mieć pełne ręce roboty. To architektura zaprojektowana nie pod „szybsze GPU”, ale pod zupełnie nowy model projektowania chmury.

Dla osób zajmujących się profesjonalnym IT kluczowy jest jeden fakt: Nvidia przestaje projektować pojedyncze komponenty. Vera Rubin to nie chip, a platforma, symbioza dziewięciu wyspecjalizowanych procesorów, działających jak jeden organizm. Jeśli myśleliście, że chłodzenie cieczą przy Blackwellu było wyzwaniem, przygotujcie się na kolejną ligę.

Nvidia Vera Rubin GPU: 3 nanometry i 1.8 kW mocy

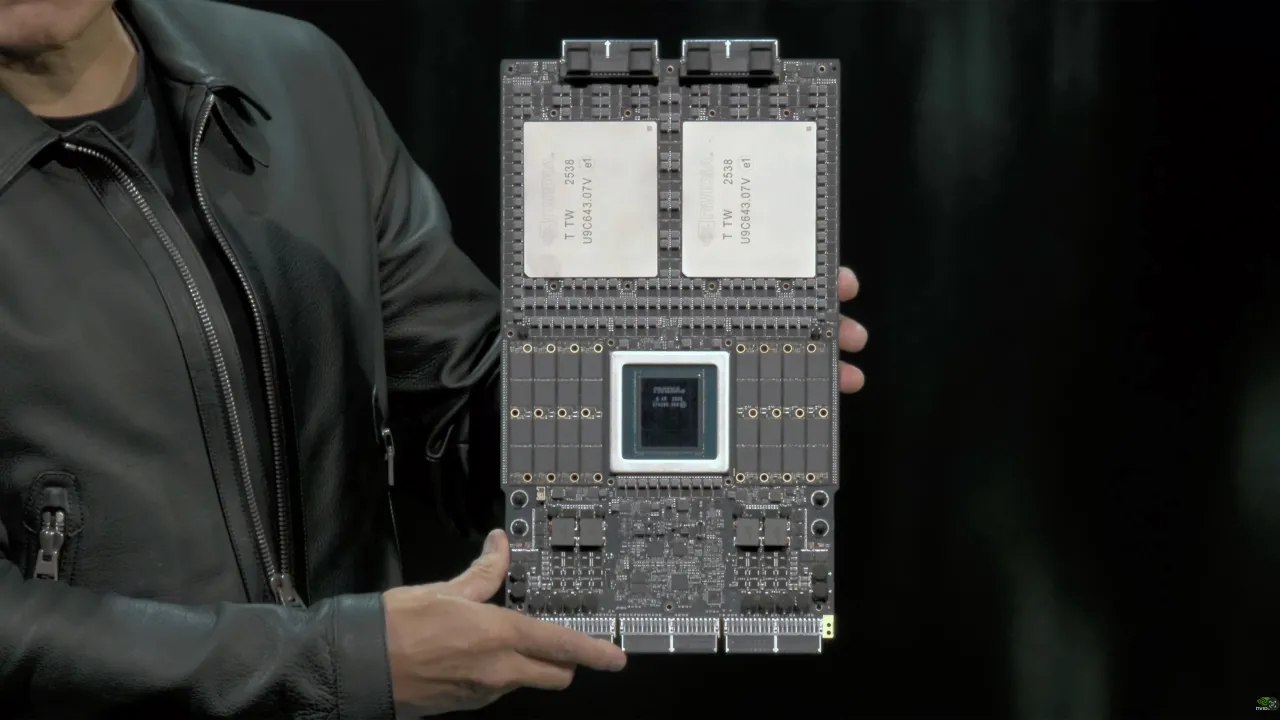

Sercem Rubina jest układ Rubin GPU (R200). Nvidia korzysta tu z 3-nanometrowego procesu TSMC oraz zaawansowanego interposera CoWoS-L, łączącego dwa potężne chipletowe kafle obliczeniowe z dedykowanymi układami I/O. Do tego dochodzi coś, co stanie się standardem dla HPC i AI: pamięć HBM4 w konfiguracji 288 GB i zawrotne 13 TB/s przepustowości.

Efekt? 50 PetaFLOPS FP4 w jednym pakiecie, ponad trzykrotny skok względem Blackwell Ultra. Ale jest też druga strona medalu. Rubin GPU ma pobierać ok. 1.8 kW, czyli o 400 W więcej niż obecna generacja. W skali racka oznacza to wejście w erę, w której chłodzenie powietrzem staje się eksponatem muzealnym, a operatorzy centrów danych muszą myśleć kategoriami instalacji przemysłowych.

NVIDIA Vera CPU: Koniec z „gotowcami” od Arm

Jeszcze ciekawiej robi się w przypadku procesora centralnego. Vera CPU to rozstanie z gotowymi rdzeniami Arm Neoverse. Nvidia stawia na 88 rdzeni Armv9.2 Olympus, zaprojektowanych wyłącznie pod obciążenia AI.

Wydajność ma być dwukrotnie wyższa niż w Grace, ale kluczowy jest inny element: łącze NVLink-C2C, które zapewnia 1.8 TB/s komunikacji CPU↔GPU. To eliminuje wąskie gardła, które dziś hamują modele multimodalne, systemy agentowe i konteksty liczone w milionach tokenów.

NVIDIA Rubin CPX: Specjalizacja to klucz do oszczędności

Najciekawszą nowością dla architektów chmury może być Rubin CPX, nowy typ akceleratora zoptymalizowanego pod inferencję kontekstową (prefill/context). To CPX bierze na siebie ciężkie, „tekstowe” wczytywanie ogromnych kontekstów, zanim Rubin GPU zacznie właściwą generację.

Rubin CPX to akcelerator wyspecjalizowany w tzw. inferencji kontekstowej (prefill/context), czyli w „czytaniu” i przetwarzaniu ogromnych ilości danych przez modele językowe, zanim te wygenerują odpowiedź. Zamiast drogiej pamięci HBM, CPX wykorzystuje 128 GB pamięci GDDR7. Efekt? Układ jest chłodniejszy, tańszy w produkcji i idealnie odciąża główne jednostki Rubin, które mogą skupić się na najcięższych obliczeniach. Nad wszystkim czuwa nowe oprogramowanie Dynamo, które automatycznie żongluje zadaniami między różnymi typami procesorów.

Infrastruktura sieciowa: Światło wchodzi do gry

Platformę dopełnia BlueField-4 DPU. To nie jest zwykła karta sieciowa, a 64-rdzeniowy komputer wewnątrz komputera, który przejmuje na siebie całą logistykę danych, szyfrowanie i bezpieczeństwo. W połączeniu z nowymi kartami ConnectX-9 SuperNIC, Nvidia wprowadza do gry fotonikę krzemową (CPO – Co-Packaged Optics). Mówimy tu o transferach rzędu 1.6 Tb/s na port. Przy takich prędkościach opóźnienia w komunikacji między szafami serwerowymi przestają mieć znaczenie.

Co to oznacza dla branży?

Gotowa szafa serwerowa NVL144, integrująca 144 GPU Rubin i 36 CPU Vera, ma dostarczać zawrotne 3.6 ExaFLOPS mocy w inferencji AI. To poziom superkomputerów narodowych, zamknięty w jednym racku.

Nvidia wysyła jasny sygnał. Era uniwersalnych serwerów w AI się kończy. Nadchodzi czas hyper-specjalizacji, gdzie każdy wat energii i każdy nanometr krzemu ma swoje ściśle określone zadanie. Dla branży IT oznacza to konieczność szybkiej adaptacji, od modernizacji zasilania, po całkowitą przebudowę systemów chłodzenia.

Premiera platformy planowana jest na przełom 2025/2026, ale cała branża infrastruktury AI już wchodzi w etap, w którym najważniejsze pytanie nie brzmi: „jak szybki jest GPU?”, tylko „czy nasze centrum danych jest w ogóle gotowe na to, co nadchodzi?”.