Przez lata podkręcanie podzespołów komputerowych stanowiło sposób na zyskanie wyższej wydajności, bez konieczności wydawania dodatkowych pieniędzy. Ostatnio jednak nietrudno odnieść wrażenia, że overclocking stracił na znaczeniu. Do napisania tego tekstu skłoniły mnie wewnętrzne refleksje, z racji, że od lat poniekąd byłem powiązany z polską sceną OC.

Spis treści

Obecnie posiadany przeze mnie komputer jest pierwszym od prawie 20 lat, w którym procesor czy karta graficzna nie zostały podkręcone. Co bardziej może dziwić części, które wybrałem wciąż to umożliwią. I choć małymi kroczkami nawet wracam do swojego hobby sprzed lat – ekstemalne podkręcanie- to, nie mogę pozbyć się z wrażenia, że overclocking już dziś nie znaczy za wiele, a jest tylko głośno wypowiadanym hasłem marketingowym.

Kiedyś, było lepiej?

Podkręcanie osiągów komputerów na pewno nie jest nowym zagadnieniem. Towarzyszy nam tak naprawdę od samego początku istnienia domowych PC, czy innych sprzętów elektronicznych. Początkowo nawet sami producenci podbijali częstotliwości układów scalonych, wychodząc poza specyfikację, w celu zapewnienia odpowiedniego poziomu wydajności. Jednak największą popularność proceder ten zyskał pod koniec lat 90 i na początku lat 2000. Czemu?

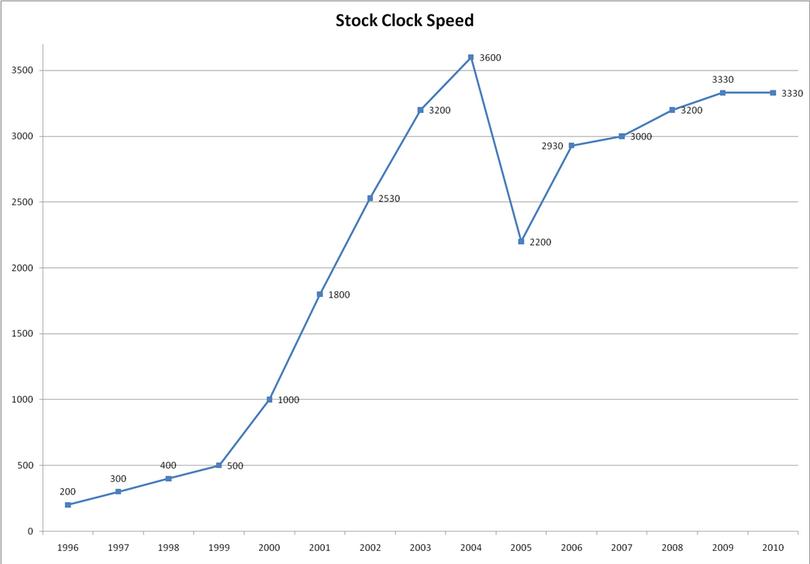

Powodów jest kilka. Przede wszystkim duży wzrost znaczenia Internetu. Komputery, które były kojarzone z maszynami do pisania, czy stacjami dla prostych gierek, nagle zaczęły być postrzegane jako okno na świat. Dodatkowo w tym okresie mogliśmy zauważyć największy wzrost wydajności. Jeszcze na początku 1998 roku standardem były procesory pracujące z częstotliwością 200 MHz. Niespełna dwa lata później jednostki centralne przekraczały już ponad 1 GHz.

Łatwo można się domyślić, że nie każdego wtedy, podobnie jak teraz, było stać na wymianę sprzętu po roku czasu. Niestety branża rozrywkowa nie stała w miejscu. Oznaczało to, że wielu użytkowników posiadało starszy sprzęt, który nie spełniał wymagań nowych gier czy programów. Entuzjaści komputerowi zaczęli, przetaktowywać swoje maszyny, dzieląc się swoimi doświadczeniami na forach internetowych. Zwiększała się również świadomość użytkowników, na co zwracać uwagę, przy wyborze nawet używanego sprzętu. I podobnie jak ma to miejsce w każdej dziedzinie naszego życia, hobby przerodziło się w swoistą rywalizację. Zaczęto porównywać osiągi, w różnych programach, powstały również pierwsze benchmarki. Dodatkowo Overclocking pozwalał zaoszczędzić, przedłużając “okres przydatności” naszego PC. Nikt nie chciał wydawać góry pieniędzy na najmocniejszy sprzęt, który za pół roku i tak będzie już przestarzały.

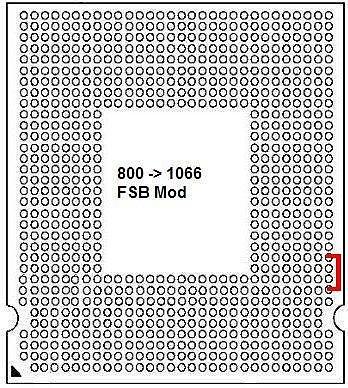

Sama scena overclockerska, była bardzo zaangażowana i zaawansowana, a użytkownicy studiowali wszelką możliwą dokumentację, by wynaleźć nowe metody zwiększenia wydajności. Tak oto opracowano mody polegające na odblokowywaniu pamięci cache ołówkiem, czy “PIN mody” w gnieździe CPu umożliwiające zmiany mnożnika zablokowanych procesorów AthlonXP. Nawet prosty BSEL mod, zmieniający częstotliwość bazową szyny, na procesorach Intela umożliwiał podkręcenie tych układów na płytach głównych z “komputerów biurowych”.

Podkręcanie zyskało tak na popularności, że stało się nieodłącznym elementem recenzji sprzętu. Użytkownicy zwracali uwagę już nie tylko na procesory, ale również na płyty główne umożliwiające osiągniecie jak najlepszych rezultatów, czy najwydajniejsze układy chłodzenia. To przecież właśnie dzięki ponadprzeciętnym możliwością na overclocking, taką popularnością i poniekąd już sentymentem po dziś dzień cieszą się procesory takie jak Core2Duo E8400, E6300, E6600 czy Core2Quad Q6600. I mimo że nie były to najdroższe czy najwydajniejsze układy wypuszczone w tamtych latach to właśnie dzięki temu, że umożliwiały one “za darmo” podbicie zegara o ponad 1 GHz, takimi się stawały.

Zresztą podobną sytuację mogliśmy zaobserwować w obozie AMD. Za czasów Atlonów 64 czy późniejszych Phenomów trzeba było zwracać uwagę, nawet na rodzaj rdzenia, bo tylko nieliczne umożliwiały dobre przetaktowywanie. Dodatkowo niektóre jednostki umożliwiały odblokowanie dodatkowych rdzenni. I tak np. kupując tani dwurdzeniowy procesor i odpowiednią płytę główną mogliśmy się cieszyć pełnosprawnym czterordzeniowym układem za ułamek ceny.

Rozwój technologii przyczyną upadku overclockingu?

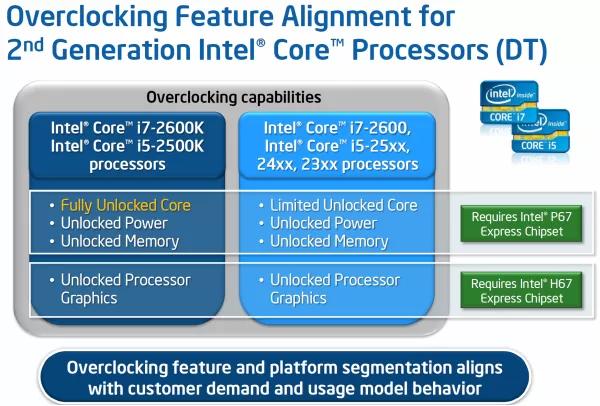

Niestety, sielanka nie trwała wiecznie. W 2011 roku Intel zrewolucjonizował podkręcanie procesorów, prezentując odblokowane procesory 2 generacji Core i z dopiskiem “K”, które towarzyszą nam po dziś dzień. Choć podobne jednostki istniały wcześniej (nazywane Extreme Edition) nie cieszyły się popularnością z racji na wysoką cenę. Dodatkowo nie zapewniały wcale wyższych osiągów w warunkach domowych, gdzie większość użytkowników była w stanie osiągnąć podobne rezultaty dzięki zmianie częstotliwości szyny głównej (FSB). Jednak jednostki Sandy Brige zostały jej pozbawione, a w jej miejsce zastosowano zegar bazowy (BCLK). Dodatkowo został on połączony ze wszystkimi portami, w tym zegarem szyny PCIe i SATA, co skutecznie uniemożliwiło jego znaczne podbicie. Często przekroczenie nawet 3 MHz powodowało zawieszenie komputera, niestabilną pracę systemu czy błędy aplikacji. Chcąc przetaktować procesor poniekąd zmuszeni byliśmy zakupić najdroższy wariant i5 bądź i7 z magicznym “K” na końcu symbolu.

Biorąc pod uwagę, jaki przyrost byliśmy w stanie osiągnąć na jednostkach Sandy Bridge czy ich następcy Ivy Bridge, wielu entuzjastów, w tym i ja sam przełknęliśmy tę gorzką pigułkę i kupowaliśmy odblokowane procesory Intela. Niestety brak konkurencji nie ułatwiał całej sytuacji. Procesory Buldozer AMD reklamowane jako pierwsze ośmiordzeniowe jednostki, okazały się co by nie mówić wtopą. Nie tylko nie zapewniały odpowiedniej wydajności, to dodatkowo strasznie się grzały.

Intel przez kolejne lata serwował nam czterordzeniowe układy zapewniając nam co najwyżej 10% wzrost wydajności między generacjami. Jednak z każdą serią rosła częstotliwość bazowa procesorów. I choć overclocking był dalej możliwy to przestawał mieć znaczenie. Głownie za sprawą rozwoju takich technologii jak Turbo Boost. Producenci nie tylko procesorów, ale i kart graficznych zdali sobie sprawę, że przez lata w ich układach krzemowych, drzemała niewykorzystywana moc. Dzięki technologiom dynamicznego podbicia zegara można było po nią sięgnąć. Umieszczając specjalne algorytmy sterujące w BIOS, można było regulować częstotliwością zależnie od obciążenia czy temperatur.

Nietrudno nie nazwać tego rozwiązania automatycznym podkręcaniem. I to, co dla większości użytkowników jest wygodnym rozwiązaniem, to dla zwolenników OC stało się powodem do wątpliwości o sensowność całego procesu. Dla przykładu, dziś różnica w wyniku w 3Dmark Royal na RTX 4090 między kartą chłodzą standardowo, a za pomocą ciekłego azoty wynosi często ok. 10%.

Marketing, który zabija

Przeglądając obecnie półki sklepowe nietrudno nie odnieść wrażenia, że overclocking stał się hasłem marketingowym. Wiele kart graficznych poza dumnie brzmiącą nazwą modelu musi po prostu mieć dopisek OC. Pytanie tylko po co, skoro zegary czy to rdzenia, czy pamięci często są podniesione o skromne kilkanaście MHz. Te wartości nawet nie przekładają się na realny zysk w wydajności. Pamiętajmy, że w głównej mierze sterowanie taktowaniem rdzenia odbywa się przez wspomniane już mechanizmy turbo. Jednak zawsze jest to pretekst do podniesienia ceny. Zwróćcie uwagę, że ten sam model bez dopisku “OC” w nazwie często jest nawet o kilkadziesiąt (a czasem kilkaset) złotych tańszy.

Takie ukierunkowanie wyłącznie na overclocking bywa również zgubne. Przez ostatnie lata pożegnaliśmy się z rynku z wieloma cenionymi markami. Starsi użytkownicy na pewno z sentymentem wspominają DFI, Abita, BFG. To na tych konstrukcjach najczęściej podkręcaliśmy procesory AMD na socket 462, czy Intelowe Pentiumy 4 i pierwsze jednostki Core2 na Socket 478 czy LGA775. Jednak mimo dopracowanych BIOSów i renomy wśród zaawansowanych użytkowników, nie wystarczyło to, by utrzymać się rynku. Często też przyczyną klęski było odejście jeden kluczowej osoby z zespołu inżynierów, choć nie zawsze. Dobrym przykładem jest choćby rezygnacja EVGA ze sprzedaży kart graficznych, z których przecież była najbardziej znana. Jednak rosnące ceny produkcji, czy nawet konkurencja bezpośrednia, że stroni NVIDII (modele Founders), nie pozostawiła możliwości podjęcia innej decyzji.

W przypadku płyt głównych też przecież często podkreśla się “moc” sekcji zasilania. I choć element ten jest ważny, to prawidłowo zaprojektowany nie ma żadnego wpływu na wydajność naszego procesora. Cóż ilość faz jest ważna, jedynie kiedy planujemy ekstremalne podkręcanie z wykorzystaniem ciekłego azotu. Jednak tutaj pojawia się pewien problem, jest to…

Hobby, dla bogatych

Przez lata przyzwyczailiśmy się że sprzęt z dopiskiem dla graczy po prostu musi być droższy. Cóż magiczny dopisek “For Gamers”, agresywna stylistyka produktu wpadająca w oko i już cena na półce o te kilkaset złotych wyższa. Podobnie jest w przypadku podzespołów przeznaczonych dla overclockerów. Wystarczy spojrzeć na ceny topowych płyt głównych czy kart graficznych od wszystkich producentów. Skrajnymi przypadkami są nawet konstrukcje umożliwiające podkręcanie na ciekłym azocie, często pozbawiane licznych funkcji czy posiadające mniejszą liczbę portów M.2, Sata, PCie czy dla pamięci RAM, które są zauważalnie droższe i to nawet o 15-20 %. Niestety przeważnie te modele są produkowane w limitowanych ilościach, a i same użyte komponenty są najwyżej jakości np. w przypadku sekcji zasilania również są najwyżej klasy, to wciąż niesmak pozostaje.

W przypadku kart graficznych również możemy zaobserwować podobną sytuację. Topowe modele jak Hall Of Fame od KFA2/GALAX kosztuje zauważalnie więcej. Dodatkowo co raz to więcej producentów wycofuje się z przygotowywania tak drogich i dopakowanych wersji. W wyścigu o bicie kolejnych rekordów nie mamy już EVGA, a wśród innych producentów nie widać chęci by zając po nich miejsce. Asus przestał prezentować modele z serii ROG Matrix, podobnie jak MSI porzuciło swoje Lightningi. Cóż po prostu się nie opłaca.

Dlatego uważam, że overclocking to obecnie hobby dla bogatych i nie ma nic wspólnego z tym co reprezentował na początku swojego powstania. Bo jak nazwać inaczej sytuację, gdzie tylko 3 modele procesorów Intela (i to najdroższe) umożliwiają ten proces i to pod warunkiem posiadania płyty głównej opartej na topowym chipsecie. Co wnosi “odblokowanie” procesorów Ryzen, skoro te przy ręcznym OC osiągają dużo niższe zegary niż w trybach turbo.

Szkoda, choć po części rozumiem taki zabieg. Zdaję sobie sprawę, że wypuszczenie na rynek odblokowanej wersji Core i3-12100 czy Core i5-12400, mogłaby skutecznie ograniczyć sprzedaż wyższych modeli. Wycofanie się z produkcji topowych serii kart graficznych, gdzie najwyższe modele i tak kosztują po kilkanaście tysięcy złotych, wydaje się nawet ukłonem w stronę użytkowników. Każdy producent przecież dąży do maksymalizacji swojego zysku i dokładnie wie co mu się sprzedaje, a co nie.

Takim zapaleńcom jak ja zostaję się zatem cieszyć z tego co mamy i że reszta branży IT nie podążyła drogą Apple blokując jakąkolwiek możliwość ingerencji w posiadany system.